Capitulo01_Luger

-

Upload

bruna-nascimento -

Category

Documents

-

view

217 -

download

0

Transcript of Capitulo01_Luger

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 1/27

1.1 DO ÉDEN AO ENIAC: POSICIONAMENTOS EM RELAÇÃO ÀINTELIGÊNCIA, AO CONHECIMENTO E À ASTÚCIA HUMANA

Prometeu fala dos frutos da sua transgressão contra os deuses do Olimpo: o seu propósito nãoera apenas se apossar do fogo para a raça humana, mas também iluminar a humanidade atravésdo dom da inteligência ou do bom senso: a “mente racional”. Esta inteligência forma o funda-mento de toda a tecnologia humana e, por fim, de toda a civilização humana. A obra do drama-turgo clássico grego ilustra uma consciência profunda e antiga do poder extraordinário do co-

nhecimento. A inteligência artificial, no que concerne mais diretamente ao dom de Prometeu,foi aplicada a todas as áreas de seu legado – medicina, psicologia, biologia, astronomia, geolo-gia – e muitas áreas do empreendimento humano que Ésquilo não poderia imaginar.

A ação de Prometeu para libertar a humanidade da doença e da ignorância angariou tam-bém a ira de Zeus. Indignado pelo roubo do conhecimento, que anteriormente pertencia ape-nas aos deuses do Olimpo, Zeus ordenou que Prometeu fosse acorrentado a uma pedra paraser assolado pelos elementos, por toda eternidade. A noção de que os esforços humanos paraganhar conhecimento constituem uma transgressão contra as leis de Deus ou da natureza es-tá profundamente arraigada ao pensamento ocidental. Esta é a base da história do Éden e queaparece na obra de Dante e de Milton. Tanto Shakespeare quanto os autores das tragédias clás-

sicas gregas retrataram a ambição intelectual como causa de desastres. A crença que o desejopor conhecimento deve levar, por fim, ao desastre, tem persistido ao longo de toda a história,resistindo ao Renascimento, à Era do Iluminismo e mesmo aos avanços científicos e filosófi-cos dos séculos XIX e XX. Assim, não deveríamos ficar surpresos por a inteligência artificialcausar tanta controvérsia, tanto em círculos acadêmicos como populares.

CAPÍTULO 1

IA: História e Aplicações

Ouça o resto e você irá se admirar ainda mais com as habilidades e os recursos que eu adquiri. O

maior deles é o seguinte: antigamente, se uma pessoa ficasse doente, ela não teria defesa contra a

doença, quer seja por alimento ou bebida curativa, nem por ungüento; assim, pela falta de medi-

camentos, os homens iam definhando, até que eu mostrei a combinação de símplices suaves com

a qual eles expulsam todo tipo de doenças...

Fui eu quem tornou visível aos olhos dos homens os sinais flamejantes do céu que havia antes do

escurecer. Chega deste assunto! Abaixo da terra, as bênçãos escondidas do homem, cobre, ferro,

prata e ouro – haverá alguém para alegar que as descobriu antes de mim? Ninguém, com certeza,

que esteja disposto a dizer a verdade sobre isso. Uma breve frase explicará toda a história: toda aarte que os mortais possuem vem de Prometeu.

ÉSQUILO , Prometeu Acorrentado

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 2/27

De fato, ao invés de dispersar este medo antigo das conseqüências da ambição intelectual,a tecnologia moderna apenas fez com que estas conseqüências parecessem iminentes. A len-da de Prometeu, de Eva e de Fausto foi recontada na linguagem da sociedade tecnológica. Nasua introdução de Frankenstein, com o interessante subtítulo de O Moderno Prometeu, MaryShelley escreve:

Muitas e longas foram as conversas entre Lord Byron e Shelley, nas quais fui um ouvinte devotadoe silencioso. Durante uma dessas conversas, várias doutrinas filosóficas foram discutidas e, entreoutras, a natureza do princípio da vida e se havia alguma possibilidade de um dia ela ser descober-ta ou comunicada. Eles falaram sobre os experimentos do Dr. Darwin (eu não falo do que o doutorrealmente fez ou disse que fez, mas do que foi dito que ele fez), que preservou um pedaço de ale-tria num pote de vidro até que, por algum meio extraordinário, ela começou a se mover com movi-mentos voluntários. Nem assim, apesar de tudo, seria gerada a vida. Talvez um cadáver pudesse serreanimado; o galvanismo tem dado indícios disso: talvez as partes componentes de uma criaturapossam ser fabricadas, montadas e dotadas do calor vital (Butler, 1998).

Shelley nos mostra em que grau avanços científicos, como a obra de Darwin e a desco-berta da eletricidade, têm convencido até mesmo não cientistas de que o funcionamento da na-

tureza não é um segredo divino, mas pode ser analisado e entendido sistematicamente. Omonstro de Frankenstein não é o produto de magia xamanística ou de pactos indescritíveiscom o mundo das trevas: ele foi montado a partir de componentes “fabricados” separadamen-te e infundidos com a força vital da eletricidade. Embora a ciência do século XIX fosse ina-dequada para concretizar o objetivo de entender e criar um agente totalmente inteligente, elaafirmava a noção de que os mistérios da vida e do intelecto podem ser trazidos à luz da análi-se científica.

1.1.1 Fundamentos Históricos

No tempo em que Mary Shelley finalmente, e talvez irrevogavelmente, uniu a ciência moder-na ao mito de Prometeu, os fundamentos filosóficos do trabalho moderno em inteligência ar-tificial já haviam sido desenvolvidos durante milhares de anos. Embora as questões morais eculturais levantadas pela inteligência artificial serem tanto interessantes como importantes, anossa introdução está mais preocupada com a herança intelectual da IA. O ponto de partidalógico para esta história se encontra em Aristóteles, ou, como Dante se refere a ele, “o mestredaqueles que sabem”. Aristóteles costurou o entendimento, o deslumbramento e os medos datradição clássica grega com a análise cuidadosa e o pensamento disciplinado que se tornaramo padrão para a ciência moderna.

Para Aristóteles, o aspecto mais fascinante da natureza é a sua transformação. Na sua obraFísica, ele define a sua “filosofia da natureza” como o “estudo das coisas que se modificam”.

Ele faz distinção entre a matéria e a forma das coisas: uma escultura é modelada a partir domaterial bronze e tem a forma humana. A transformação ocorre quando o bronze é moldadocom a nova forma. A distinção entre matéria e forma fornece uma base filosófica para noçõesmodernas, como a computação simbólica e a abstração de dados. Em computação (mesmocom números), manipulamos padrões que são as formas de material eletromagnético, com asmudanças de forma deste material representando aspectos do processo de solução. A abstra-ção da forma do substrato de sua representação não apenas permite que estas formas sejammanipuladas computacionalmente, mas também proporciona a promessa de uma teoria de es-truturas de dados, o cerne da ciência da computação moderna.

Em sua obra Metafísica, Aristóteles desenvolve uma ciência das coisas que nunca se mo-

dificam, incluindo as suas cosmologia e teologia. Entretanto, mais relevante para a inteligên-cia artificial é a epistemologia de Aristóteles, ou a ciência do conhecimento, discutida em suaobra Lógica. Aristóteles se referia à sua lógica como um “instrumento” (organon) porque per-cebeu que o estudo do pensamento propriamente dito era a base para todo o conhecimento.

26 INTELIGÊNCIA ARTIFICIAL

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 3/27

Em sua Lógica, ele investiga se certas proposições podem ser “verdadeiras” porque estão re-lacionadas com outras coisas que são sabidamente verdadeiras. Assim, se sabemos que “todosos homens são mortais” e que “Sócrates é um homem”, então podemos concluir que “Sócra-tes é mortal”. Este argumento é um exemplo do que Aristóteles se referia como um silogismousando a forma dedutiva modus ponens. Embora tenham sido necessários outros 2 mil anosaté que a axiomatização formal do raciocínio tivesse florescido completamente nas obras de

Gottlob Frege, Bertrand Russel, Kurt Gödel, Alan Turing, Alfred Tarski e outros, as suas raí-zes remontam a Aristóteles.O pensamento do Renascimento, construído sobre a tradição grega, deu início à evolução

de um modo diferente e poderoso de pensar a cerca da humanidade e de sua relação com omundo natural. O empiricismo começou a substituir a misticismo como meio de entender anatureza. Relógios e, eventualmente, horários de fábricas sobrepujaram os ritmos da nature-za para milhares de habitantes urbanos. A maioria das ciências sociais e físicas modernas temsua origem na noção de que processos, quer sejam eles naturais ou artificiais, poderiam sermatematicamente analisados e entendidos. Em particular, cientistas e filósofos perceberamque o pensamento em si, o modo como o conhecimento é representado e manipulado na men-te humana, era um tema difícil, mas essencial, para ser estudado cientificamente.

Talvez o evento principal no desenvolvimento da visão moderna de mundo tenha sido arevolução causada por Copérnico, que substituiu o antigo modelo geocentrista do universo pe-la idéia de que, na verdade, a Terra e os outros planetas se movimentam em torno do Sol. Apósséculos de uma ordem “óbvia”, na qual a explicação científica da natureza do cosmos era con-sistente com os ensinamentos religiosos e de senso comum, foi proposto um novo modelodrasticamente diferente e nada óbvio para explicar o movimento dos corpos celestes. Pela pri-meira vez, provavelmente, as nossas idéias a cerca do mundo foram vistas como fundamen-

talmente distintas de sua aparência. Esta separação entre a mente humana e a sua realidadecircundante, entre idéias sobre coisas e as coisas propriamente ditas, é essencial ao estudo mo-derno da mente e da sua organização. Esta brecha foi alargada pelos escritos de Galileu, cujas

observações científicas contradiziam ainda mais as verdades “óbvias” sobre o mundo natural,e cujo desenvolvimento da matemática como ferramenta para descrição do mundo enfatizavaa distinção entre o mundo e as nossas idéias sobre ele. É desta brecha que a noção moderna demente evoluiu: a introspecção se tornou um tema comum na literatura, filósofos começarama estudar matemática e epistemologia, e a aplicação sistemática do método científico come-çou a competir com os sentidos como ferramenta para entendimento do mundo.

Embora os séculos XVII e XVIII tenham presenciado uma grande quantidade de traba-lhos em epistemologia e em outros campos relacionados, temos espaço aqui para discutir ape-nas a obra de René Descartes. Descartes é uma figura central no desenvolvimento dos concei-tos modernos de pensamento e mente. Na sua famosa obra Meditações, Descartes procura en-

contrar uma base para a realidade tão-somente através da introspecção cognitiva. Sistemati-camente rejeitando os seus sentidos como indignos de confiança, Descartes foi forçado a du-vidar até mesmo da existência do mundo físico e se viu deixado apenas com a realidade dopensamento; mesmo a sua própria existência teve de ser justificada em termos do pensamen-to: “Cogito ergo sum” (penso, logo existo). Após ter estabelecido a sua própria existência me-ramente como uma entidade pensante, Descartes inferiu a existência de Deus como um cria-dor essencial e, por fim, reafirmou a realidade do universo físico como a criação necessária deum Deus generoso.

Aqui, podemos fazer duas observações interessantes: primeiro, o cisma entre a mente e omundo físico se tornou tão completo que o processo de pensar poderia ser discutido de formaisolada de qualquer estímulo sensorial específico ou qualquer outra questão mundana; segun-do, a conexão entre a mente e o mundo físico era tão tênue que requeria a intervenção de umDeus generoso para permitir o conhecimento confiável do mundo físico! Esta visão da duali-dade entre a mente e o mundo físico forma a base de todo o pensamento de Descartes, incluin-do o seu desenvolvimento da geometria analítica. Como então ele poderia ter unificado um ra-

IA:HISTÓRIA E APLICAÇÕES 27

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 4/27

mo da matemática aparentemente tão mundano como a geometria, com uma estrutura mate-mática tão abstrata como a álgebra?

Por que incluímos esta discussão filosófica num texto de inteligência artificial? Há duasconseqüências desta análise que são essenciais para o empreendimento da inteligência artificial:

1 Pela separação entre a mente e o mundo físico, Descartes e outros pensadores es-tabeleceram que a estrutura das idéias sobre o mundo não era necessariamenteigual à estrutura do seu tema de estudo. Este fato forma a base da metodologia docampo da IA, juntamente com os campos da epistemologia, psicologia, grandeparte da matemática superior e a maior parte da literatura moderna: os processosmentais têm uma existência própria, obedecem às suas próprias leis e podem serestudados em e sobre si mesmos.

2 Uma vez que a mente e o corpo foram separados, os filósofos sentiram a necessi-dade de encontrar um meio de reconectar os dois, porque a interação entre os pla-nos mental, res cogitans, e físico, res extensa, é essencial para a existência da hu-manidade.

Embora tenham sido escritos milhões de palavras sobre o problema mente-corpo e te-nham sido propostas numerosas soluções, ninguém teve sucesso em explicar as interações ób-vias entre os estados mentais e as ações físicas, ao mesmo tempo afirmando as diferenças fun-damentais entre eles. A resposta mais amplamente aceita para este problema, e aquela que for-nece um fundamento essencial para o estudo da IA, propõe que a mente e o corpo não sejam,de modo algum, entidades fundamentalmente diferentes. Segundo esta visão, os processosmentais são realmente realizados por sistemas físicos, tais como o cérebro (ou os computado-res). Os processos mentais, como processos físicos, podem ser basicamente caracterizadosatravés da matemática formal. Ou, como formulado pelo filósofo do século XVII Hobbes(1651), “Raciocinar é calcular”.

1.1.2 O Desenvolvimento da Lógica

Uma vez que pensar passou a ser visto como uma forma de computação, a sua formalizaçãoe eventual mecanização seriam obviamente os próximos passos. No século XVII, GottfriedWilhelm von Leibniz, com o seu Calculus Philosophicus, introduziu o primeiro sistema de ló-gica formal, bem como construiu uma máquina para automatizar o seu cálculo (Leibniz,1887). Euler, no século XVIII, com a sua análise da “conectividade” das pontes ligando osbancos de areia e ilhas da cidade de Königsberg (veja a introdução do Capítulo 3), introduziuo estudo de representações que capturam, de modo abstrato, a estrutura dos relacionamentos

que ocorrem no mundo (Euler, 1735).A formalização da teoria dos grafos proporcionou, também, a possibilidade da busca no

espaço de estados, uma ferramenta conceitual importante da inteligência artificial. Podemosusar grafos para modelar a estrutura mais profunda de um problema. Os nós de um grafo de

espaço de estados representam estágios possíveis de uma solução do problema; os arcos dografo representam inferências, movimentos num jogo ou outros passos numa solução do pro-blema. Resolver o problema é um processo de buscar no grafo de espaço de estados um cami-nho para uma solução (Seção 1.3 e Capítulo 3). Por descreverem o espaço completo de solu-ções do problema, os grafos de espaço de estado se constituem numa ferramenta poderosa pa-ra se medir a estrutura e a complexidade de problemas e analisar a eficiência, correção e ge-

neralidade de estratégias de solução.Como um dos criadores da ciência da pesquisa operacional, bem como o projetista dasprimeiras máquinas computacionais mecânicas programáveis, Charles Babbage, um matemá-tico do século XIX, pode ser também considerado um dos pioneiros da inteligência artificial(Morrison e Morrison, 1961). O “motor diferencial” de Babbage era uma máquina de propó-

28 INTELIGÊNCIA ARTIFICIAL

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 5/27

sito específico para calcular os valores de certas funções polinomiais e foi a precursora de seu“motor analítico”. O motor analítico, concebido, mas não construído, com sucesso durante asua vida, era uma máquina computacional programável de propósito geral que anteviu muitasdas suposições arquitetônicas que formam a base do computador moderno.

Descrevendo o motor analítico, Ada Lovelace (1961), amiga, incentivadora e colaborado-ra de Babbage, disse:

Podemos afirmar muito apropriadamente que o Motor Analítico tece padrões algébricos do mesmomodo que o tear de Jacquard tece flores e folhas. Aqui, nos parece, reside muito mais originalida-de do que se poderia atribuir ao motor diferencial.

A inspiração de Babbage era o desejo de aplicar a tecnologia de seu tempo para libertar ohomem da árdua tarefa dos cálculos aritméticos. Neste sentido, bem como dentro da sua con-cepção de computadores como dispositivos mecânicos, Babbage pensava em termos pura-mente do século XIX. O seu motor analítico, entretanto, também incluía muitas noções mo-dernas, como a separação entre memória e processador (o “depósito” e o “moinho”, em ter-mos de Babbage), o conceito de uma máquina digital ao invés de uma máquina analógica, e a

noção de programabilidade baseada na execução de uma série de operações codificadas emcartões de papelão. A característica mais impressionante na descrição de Ada Lovelace, e emtoda a obra de Babbage, é o seu tratamento dos “padrões” de relacionamentos algébricos co-mo entidades que podem ser estudadas, caracterizadas e, enfim, implementadas e manipula-das mecanicamente sem a preocupação com valores particulares que são, por fim, passadosatravés do “moinho” da máquina de calcular. Esta é uma implementação da “abstração e ma-nipulação da forma” que foi descrita pela primeira vez por Aristóteles.

O objetivo de se criar uma linguagem formal para o pensamento também aparece na obrade George Boole, um outro matemático do século XIX, cujo trabalho deve ser incluído emqualquer discussão sobre as raízes da inteligência artificial (Boole, 1847, 1857). Embora eletenha realizado contribuições em várias áreas da matemática, o seu trabalho mais conhecidofoi na formalização das leis da lógica, uma realização que representa o coração da ciência dacomputação moderna. Embora o papel da álgebra booleana no projeto de circuitos lógicos se-

ja bem conhecido, os objetivos pessoais de Boole em desenvolver o seu sistema parecem maispróximos dos objetivos dos pesquisadores contemporâneos da IA. No primeiro capítulo deUma Investigação das Leis do Pensamento, sobre as quais estão fundamentadas as Teorias

Matemáticas da Lógica e da Probabilidade, Boole descreveu os seus objetivos como

investigar as leis fundamentais das operações mentais através das quais se realiza o raciocínio: ex-pressá-las na linguagem simbólica de um cálculo e, sobre esta base, estabelecer a ciência da lógicae instruir o seu método; ... e, por fim, coletar de vários elementos verdadeiros, revelados no decor-rer destas consultas, algumas indicações prováveis relativas à natureza e à constituição da mente hu-mana.

A grandeza da realização de Boole está no poder extraordinário e simplicidade do siste-ma que ele concebeu: três operações, “E” (representada por ∗ ou ∧ ), “OU” (representada por+ ou ∨ ) e “NÃO” (representada por ¬), formam o coração do seu cálculo lógico. Estas ope-rações permaneceram a base para todos os desenvolvimentos subseqüentes da lógica formal,incluindo a concepção dos computadores modernos. Ao mesmo tempo que mantém o signifi-cado destes símbolos praticamente idênticos às operações algébricas correspondentes, Booleobservou que “os símbolos da lógica estão adicionalmente sujeitos a uma lei especial, à qualos símbolos de quantidades, como tais, não estão sujeitos”. Esta lei diz que, para qualquer X,

que é um elemento da álgebra, X ∗ X = X (ou seja, se algo é sabidamente verdadeiro, então asua repetição não pode aumentar este conhecimento). Esta noção levou à restrição caracterís-tica dos valores booleanos a apenas dois números que podem satisfazer esta equação: 1 e 0.As definições-padrão da multiplicação booleana (E) e da adição (OU) advêm deste critério.

IA:HISTÓRIA E APLICAÇÕES 29

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 6/27

30 INTELIGÊNCIA ARTIFICIAL

O sistema de Boole não apenas forneceu a base da aritmética binária, mas também de-monstrou que um sistema formal extremamente simples era adequado para captar todo o po-der da lógica. Esta suposição, e o sistema que Boole desenvolveu para demonstrá-la, formama base de todos os esforços modernos para formalizar a lógica, desde o Principia Mathemati-

ca de Russel e Whitehead (Whitehead e Russel, 1950), passando pela obra de Turing e Gödel,até os sistemas automáticos modernos de raciocínio.

Gottlob Frege, em sua obra Fundamentos da Aritmética (Frege, 1879, 1884), criou umalinguagem de especificação matemática para descrever a base da aritmética de uma forma cla-ra e precisa. Com esta linguagem, Frege formalizou muitas das questões que foram tratadasinicialmente pela Lógica de Aristóteles. A linguagem de Frege, agora conhecida como cálcu-lo de predicados de primeira ordem, oferece uma ferramenta para descrever as proposições eatribuições de valores de verdade que compõem os elementos do raciocínio matemático e des-creve a base axiomática do “significado” para estas expressões. O sistema formal do cálculode predicados, que inclui símbolos de predicados, uma teoria de funções e variáveis quantifi-cadas, foi concebido para ser uma linguagem para descrever a matemática e suas bases filo-sóficas. Ele tem também um papel importante na criação de uma teoria de representações pa-ra a inteligência artificial (Capítulo 2). O cálculo de predicados de primeira ordem fornece asferramentas necessárias para o raciocínio automático: uma linguagem para expressões, umateoria para suposições relacionadas com o significado das expressões e um cálculo logica-mente correto para inferir novas expressões verdadeiras.

O trabalho de Russel e Whitehead (1950) é particularmente importante para a fundamen-tação da IA, uma vez que o seu objetivo declarado era derivar a matemática como um todoatravés de operações formais sobre uma coleção de axiomas. Embora muitos sistemas mate-máticos tenham sido construídos a partir de axiomas básicos, o interessante aqui é o compro-metimento de Russel e Whitehead com a matemática como um sistema puramente formal. Is-to significa que os axiomas e teoremas seriam tratados apenas como seqüências de caracteres:as provas se processariam apenas através da aplicação de regras bem definidas para manipu-

lar estas seqüências. Não se poderia confiar na intuição ou no significado de teoremas comobase para provas. Cada passo de uma prova é resultado da aplicação estrita de regras formais(sintáticas) a axiomas ou teoremas provados previamente, mesmo quando provas tradicionaispossam considerar este passo como “óbvio”. O “significado” que os teoremas e axiomas dosistema podem ter em relação ao mundo seria independente das suas derivações lógicas. Estetratamento do raciocínio matemático em termos puramente formais (e conseqüentemente me-cânicos) proporciona uma base essencial para sua automação em computadores físicos. A sin-taxe lógica e regras formais de inferência desenvolvidas por Russel e Whitehead fornecem,ainda, a base para sistemas de prova automática de teoremas, apresentados no Capítulo 12,bem como para os fundamentos teóricos da inteligência artificial.

Alfred Tarski é outro matemático cujo trabalho é essencial para o embasamento da IA.Tarski criou uma teoria de referência, através da qual se pode dizer que as fórmulas bem for -madas de Frege ou Russel e Whitehead se referem, de um modo impreciso, ao mundo físico(Tarski, 1944, 1956; ver o Capítulo 2). Esta visão serve de embasamento para a maioria dasteorias de semântica formal. No seu artigo “A concepção semântica da verdade e os funda-mentos da semântica”, Tarski descreve sua teoria de referência e relacionamentos de valoresde verdade. Vários cientistas da computação modernos, especialmente Scott, Strachey, Burs-tall (Burstall e Darlington, 1977) e Plotkin, relacionaram esta teoria com linguagens de pro-gramação e outras especificações para computação.

Embora nos séculos XVIII, XIX e início do XX a formulação da ciência e da matemáti-ca tenha criado o pré-requisito intelectual para o estudo da inteligência artificial, somente coma introdução do computador digital no século XX é que a IA se tornou uma disciplina cienti-ficamente viável. No final dos anos 40, os computadores eletrônicos digitais demonstraram

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 7/27

IA:HISTÓRIA E APLICAÇÕES 31

seu potencial para disponibilizar memória e poder de processamento requeridos pelos progra-mas inteligentes. Era possível, agora, implementar sistemas de raciocínio formal num compu-tador e testar empiricamente a sua aptidão para exibir inteligência. Um componente essencialda ciência da inteligência artificial é este compromisso com os computadores digitais comoveículo para criar e testar teorias sobre a inteligência.

Os computadores digitais não são apenas um veículo para testar teorias sobre a inteligên-

cia. A sua arquitetura sugere, também, um paradigma específico para estas teorias: inteligên-cia é uma forma de processamento de informação. A noção de busca como uma metodologiapara solução de problemas, por exemplo, está mais ligada à natureza seqüencial da operaçãodo computador do que a qualquer modelo biológico de inteligência. A maioria dos programasde IA representa o conhecimento em alguma linguagem formal que é, então, manipulada poralgoritmos, respeitando a separação entre dados e programa, que é fundamental ao estilo decomputação de von Neumann. A lógica formal emergiu como uma ferramenta representacio-nal importante para as pesquisas em IA, assim como a teoria dos grafos desempenha um pa-pel essencial na análise de espaços de problemas, bem como fornece a base para as redes se-mânticas e outros modelos similares de significado semântico. Essas técnicas e formalismossão discutidos detalhadamente ao longo de todo o texto; nós as mencionamos aqui para enfa-tizar a relação simbiótica entre o computador digital e os alicerces da inteligência artificial.

Nós esquecemos freqüentemente que as ferramentas que criamos para os nossos propó-sitos tendem a moldar a nossa concepção do mundo através das suas estrutura e limitações.Embora aparentemente restritiva, esta interação é um aspecto essencial da evolução do conhe-cimento humano: uma ferramenta (e as teorias científicas são, no final das contas, apenas fer-ramentas) é desenvolvida para solucionar um problema particular. Conforme ela é usada e re-finada, a própria ferramenta parece sugerir outras aplicações, levando a outras questões e, porfim, ao desenvolvimento de novas ferramentas.

1.1.3 O Teste de TuringUm dos primeiros artigos a tratar da questão da inteligência de máquina, especificamente emrelação ao computador digital moderno, foi escrito, em 1950, pelo matemático britânico AlanTuring e publicado em Mind . A obra “Maquinismo computacional e inteligência” (Turing,1950) permanece atual tanto em relação à sua ponderação dos argumentos contra a possibili-dade de se criar uma máquina computacional inteligente, como também pelas suas respostasa estes argumentos. Turing, que era conhecido principalmente por suas contribuições à teoriada computabilidade, abordou a questão se seria possível ou não fazer uma máquina pensar. Aonotar que as ambigüidades fundamentais contidas na própria questão (o que é pensar? o queé uma máquina?) obstruíam qualquer resposta racional, ele propôs que a questão sobre a in-

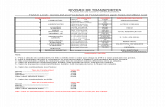

teligência fosse substituída por um teste empírico mais claramente definido.O teste de Turing mede o desempenho de uma máquina aparentemente inteligente, em re-lação ao desempenho de um ser humano, indiscutivelmente o melhor e único padrão paracomportamento inteligente. O teste, que foi chamado de “jogo de imitação” por Turing, colo-ca a máquina e o seu correspondente humano em salas separadas entre si e de um terceiro serhumano, referido como o “interrogador” (Figura 1.1). O interrogador não é capaz de ver ne-nhum dos dois participantes ou de falar diretamente com eles. Ele também não sabe qual en-tidade é a máquina, e só pode se comunicar com eles através do uso de um dispositivo textual,como um terminal. A tarefa do interrogador é distinguir o computador do ser humano utilizan-do apenas as suas respostas a perguntas formuladas através deste dispositivo. Se o interroga-dor não puder distinguir a máquina do ser humano, então, argumenta Turing, pode-se suporque a máquina seja inteligente.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 8/27

32 INTELIGÊNCIA ARTIFICIAL

FIGURA 1.1 O teste de Turing.

Isolando-se o interrogador, tanto da máquina como do outro participante humano, o tes-te assegura que ele não será influenciado pela aparência da máquina ou por qualquer outrapropriedade mecânica de sua voz. Entretanto, o interrogador é livre para fazer qualquer per-gunta, não importando quão direta ou indireta ela seja, num esforço para descobrir a identida-de do computador. O interrogador pode, por exemplo, solicitar que os dois participantes rea-lizem um cálculo aritmético bastante complicado, presumindo que seja mais provável que ocomputador realize o cálculo corretamente, do que o ser humano; para neutralizar esta estra-tégia, o computador precisa saber quando ele deve deixar de obter a resposta correta a tais pro-blemas, de modo a se parecer com um ser humano. Para descobrir a identidade humana a par-tir da sua natureza emocional, o interrogador poderia pedir para os dois participantes reagi-rem a um poema ou a uma obra de arte; esta estratégia requer que o computador tenha conhe-cimento acerca da constituição emocional dos seres humanos.

As características importantes deste teste são:

1 Ele nos dá uma noção objetiva de inteligência, isto é, o comportamento de um sersabidamente inteligente em resposta a um conjunto particular de questões. Isto nosfornece um padrão para determinar a inteligência, evitando os debates inevitáveissobre a sua “verdadeira” natureza.

2 Ele evita que sejamos desviados por estas questões confusas e atualmente irres-pondíveis, por exemplo, se um computador usa ou não os processos internos ade-quados ou se a máquina tem ou não consciência de suas ações.

3 Ele elimina qualquer viés em favor dos organismos vivos, forçando o interrogadora focar apenas no conteúdo das respostas às questões.

Por causa destas vantagens, o teste de Turing tem sido usado como base para vários esquemasrealmente utilizados para avaliar programas de IA modernos. Um programa que potencial-mente tenha adquirido inteligência em alguma área de perícia pode ser avaliado por meio dacomparação de seu desempenho em relação a um especialista humano, frente a um certo con-

junto de problemas. Esta técnica de avaliação é apenas uma variação do teste de Turing: pe-de-se que um grupo de pessoas compare às cegas o desempenho de um computador e de umser humano em relação a um conjunto de problemas. Como veremos, esta metodologia se tor-nou uma ferramenta essencial tanto no desenvolvimento quanto na verificação dos sistemasespecialistas modernos.

O teste de Turing, apesar do seu apelo intuitivo, é vulnerável a várias críticas. Uma dasmais importantes se refere ao seu viés direcionado para as tarefas de solução de problemas pu-ramente simbólicas. Ele não testa as habilidades necessárias para a perícia perceptual ou des-treza manual, muito embora elas sejam componentes importantes da inteligência humana. Por

O

INTERROGADOR

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 9/27

IA:HISTÓRIA E APLICAÇÕES 33

outro lado, existem algumas críticas que sugerem que o teste de Turing restringe desnecessa-riamente a inteligência de máquina a se encaixar no molde humano. Talvez a inteligência demáquina seja simplesmente diferente da inteligência humana, e tentar avaliá-la em termos hu-manos seja um erro fundamental. Realmente desejamos uma máquina que realize operaçõesmatemáticas de modo tão lento e inexato como o faz um ser humano? Uma máquina inteli-gente não deveria tirar proveito dos seus próprios recursos, como o fato de dispor de uma me-

mória grande, rápida e confiável, em vez de tentar emular a cognição humana? De fato, váriospraticantes da IA moderna (por exemplo, Ford e Hayes, 1995) consideram que responder to-talmente ao desafio do teste de Turing é um erro e um grande desvirtuamento da tarefa maisimportante que se apresenta: o desenvolvimento de teorias gerais para explicar os mecanis-mos da inteligência nos seres humanos e em máquinas, com a aplicação destas teorias no de-senvolvimento de ferramentas para solucionar problemas práticos, específicos. Embora con-cordemos com as preocupações de Ford e Hayes, consideramos ainda o teste de Turing comoum componente importante na verificação e validação do software de IA moderno.

Turing também tratou da real possibilidade de se construir um programa inteligente numcomputador digital. Pensando em termos de um modelo específico de computação (uma má-quina de computação eletrônica de estados discretos), ele formulou algumas conjecturas bemfundamentadas com relação à capacidade de armazenamento, complexidade do programa efilosofia básica de projeto, necessárias para este tipo de sistema. Por fim, ele discutiu uma sé-rie de objeções morais, filosóficas e científicas sobre a possibilidade de se construir um pro-grama assim em termos da tecnologia atual. O leitor deve consultar o artigo de Turing para terum quadro resumido compreensível, mas ainda assim relevante, do debate sobre as possibili-dades das máquinas inteligentes.

Duas das objeções citadas por Turing merecem uma consideração mais detalhada. A “ob- jeção de Lady Lovelace”, formulada originalmente por Ada Lovelace, argumenta que os com-putadores podem fazer apenas aquilo que lhes foi anteriormente dito, conseqüentemente nãopodendo realizar ações originais (e, portanto, inteligentes). Esta objeção se tornou uma parte

reconfortante, ainda que um tanto dúbia, do folclore tecnológico contemporâneo. Os sistemasespecialistas (Seção 1.2.3 e Capítulo 7), especialmente na área de diagnósticos, têm chegadoa conclusões não previstas pelos seus projetistas. Na verdade, vários pesquisadores conside-ram que a criatividade humana pode ser expressa num programa de computador.

A outra objeção, o “Argumento da Informalidade do Comportamento”, defende a impos-sibilidade de se criar um conjunto de regras que digam a um indivíduo exatamente o que fa-zer em todas as circunstâncias possíveis. Certamente, a flexibilidade que possibilita a uma in-teligência biológica responder a um conjunto quase infinito de situações de uma forma razoá-vel e, muitas vezes, ótima é uma característica distintiva do comportamento inteligente. Ape-sar de ser verdadeira a afirmação de que a estrutura de controle utilizada nos programas de

computador mais tradicionais não demonstra grande flexibilidade ou originalidade, não é ver-dade que todos os programas devam ser escritos desta forma. Na realidade, grande parte dosesforços em IA nos últimos 25 anos tem se concentrado no desenvolvimento de linguagens deprogramação e de modelos, tais como os sistemas de produção, os sistemas baseados em ob-

jetos, representações por redes e outros que são discutidos neste livro, que procuram superaresta deficiência.

Os programas de IA modernos consistem, geralmente, de uma coleção de componentesmodulares, ou regras de comportamento, que não são executadas segundo uma ordenação rí-gida, mas que são invocadas conforme a necessidade, em resposta à estrutura de um caso par-ticular de um problema. Os comparadores de padrões permitem a aplicação de regras geraissobre um certo conjunto de casos. Estes sistemas têm uma flexibilidade extrema que possibi-lita que programas relativamente pequenos exibam um vasto conjunto de comportamentospossíveis, em resposta a problemas e situações diferentes.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 10/27

Entretanto, se estes sistemas no final das contas podem ou não exibir a flexibilidade queum organismo vivo possui, ainda é um tema de muito debate. O prêmio Nobel Herbert Simonargumentou que muito da originalidade e variabilidade de comportamento demonstrado pelascriaturas vivas é devido à riqueza do seu ambiente e não à complexidade dos seus própriosprogramas internos. Em As Ciências do Artificial , Simon (1981) descreve a progressão tortuo-sa de uma formiga ao longo de uma extensão de solo irregular e atravancada. Embora a trilha

da formiga pareça ser bastante complexa, Simon argumenta que o objetivo da formiga é mui-to simples: retornar à sua colônia o mais rápido possível. Os giros e voltas na sua trilha sãocausados pelos obstáculos que ela encontra no seu caminho. Simon conclui:

Uma formiga, vista como um sistema comportamental, é muito simples. A aparente complexidadedo seu comportamento ao longo do tempo é, em grande parte, um reflexo da complexidade do am-biente no qual ela se encontra.

Se no final das contas for provado que esta idéia se aplica não só a criaturas simples co-mo os insetos, mas também a organismos com maior inteligência, então ela se constitui numargumento poderoso de que estes sistemas são relativamente simples e, conseqüentemente,

compreensíveis. É interessante notar que se alguém aplicar esta idéia aos seres humanos, istotorna-se um forte argumento para a importância da cultura na formação da inteligência. Emvez de crescer no escuro, como os cogumelos, a inteligência aparentemente depende de umainteração com um ambiente adequadamente rico. Cultura é tão importante na geração de se-res humanos, quanto os seres humanos o são na geração de cultura. Em vez de denegrir nos-sos intelectos, esta idéia enfatiza a riqueza milagrosa e a coerência das culturas que se forma-ram a partir das vidas de seres humanos separados. De fato, a idéia de que a inteligência emer-ge das interações de elementos individuais de uma sociedade é uma das visões que dão supor-te à abordagem para a tecnologia de IA apresentada na próxima seção.

1.1.4 Modelos Biológicos e Sociais da Inteligência: AgentesAté agora, abordamos o problema da construção de máquinas inteligentes do ponto de vistada matemática, com a crença implícita de que o raciocínio lógico é o paradigma da inteligên-cia em si, bem como com o compromisso com a fundamentação “objetiva” do raciocínio ló-gico. Esta forma de se considerar o conhecimento, a linguagem e o pensamento reflete a tra-dição racionalista da filosofia ocidental, a qual evolui através de Platão, Galileu, Descartes,Leibniz e muitos dos outros filósofos que discutimos anteriormente neste capítulo. Ela tam-bém reflete as suposições que fundamentam o teste de Turing, particularmente a sua ênfase noraciocínio simbólico como teste de inteligência, e a crença de que uma comparação diretacom um ser humano é adequada para confirmar a inteligência de máquina.

A confiança na lógica como um meio de representar conhecimento e na inferência lógicacomo o mecanismo primordial para o raciocínio inteligente é tão dominante na filosofia oci-dental que a sua “verdade” freqüentemente parece óbvia e incontestável. Portanto, não é de sesurpreender que abordagens baseadas nestas suposições têm dominado a ciência da inteligên-cia artificial desde o seu início até os dias de hoje.

Entretanto, a última metade do século XX presenciou numerosos desafios à filosofia ra-cionalista. Várias formas de relativismo filosófico questionaram a base objetiva da linguagem,da ciência, da sociedade e do próprio pensamento. A filosofia tardia de Ludwig Wittgenstein(Wittgenstein, 1953) forçou-nos a reconsiderar a base do significado, tanto da linguagem na-tural quanto da formal. Os trabalhos de Gödel e Turing puseram em dúvida os fundamentos

da própria matemática. O pensamento pós-moderno mudou o nosso entendimento sobre sig-nificado e valor nas artes e na sociedade. A inteligência artificial não ficou imune a estas crí-ticas; de fato, as dificuldades que a IA encontrou para alcançar os seus objetivos são freqüen-

34 INTELIGÊNCIA ARTIFICIAL

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 11/27

IA:HISTÓRIA E APLICAÇÕES 35

temente consideradas como evidência da deficiência do ponto de vista racionalista (Winograde Flores, 1986; Lakoff e Johnson, 1999).

Duas tradições filosóficas, a de Wittgenstein (1953), bem como a de Husserl (1970, 1972)e Heidegger (1962), são centrais a esta reconsideração da tradição filosófica ocidental. Na suaobra tardia, Wittgenstein questionou muitas das suposições da tradição racionalista, incluin-do os fundamentos da linguagem, da ciência e do próprio conhecimento. A linguagem natu-

ral foi um foco central da análise de Wittgenstein: ele desafiou a noção de que a linguagemhumana tenha derivado o seu significado a partir de qualquer tipo de fundamentação objetiva.Para Wittgenstein, bem como pela teoria do ato de falar desenvolvida por Austin (1962)

e seus seguidores (Grice, 1975; Searle, 1969), o significado de qualquer expressão vocal de-pende de onde ela se situa num contexto humano e cultural. O nosso entendimento da palavra“cadeira”, por exemplo, depende da existência de um corpo físico que corresponda a uma pos-tura sentada e às convenções culturais sobre o uso de cadeiras. Quando, por exemplo, uma pe-dra grande e plana seria uma cadeira? Por que é estranho se referir ao trono da Inglaterra co-mo uma cadeira? Qual a diferença entre o entendimento humano sobre uma cadeira e o de umcachorro ou gato, que são incapazes de sentar, no sentido humano? Com base nos seus ata-ques aos fundamentos do significado, Wittgenstein argumentou que deveríamos considerar ouso da linguagem em termos de escolhas feitas e ações realizadas num contexto cultural va-riável. Wittgenstein estendeu, inclusive, as suas críticas à ciência e à matemática, argumentan-do que elas eram construções sociais, assim como o é o uso da linguagem.

Husserl (1970, 1972), o pai da fenomenologia, estava comprometido com abstrações en-raizadas no “mundo da vida” ( Labenswelt ) concreto: um modelo racionalista é secundário emrelação ao mundo concreto que o suporta. Para Husserl, bem como para seu estudante Heideg-ger (1962) e seu oponente Merleau-Ponty (1962), a inteligência não é saber o que é verdadei-ro, mas saber como lidar com um mundo em constante modificação e evolução. Assim, pelatradição existencialista e fenomenologista, a inteligência é vista como sobrevivência no mun-do, em vez de um conjunto de proposições lógicas acerca do mundo (combinada com um es-

quema de inferência).Muitos autores, por exemplo Dreyfus e Dreyfus (1985) e Winograd e Flores (1986), con-

sideraram o trabalho de Wittgenstein e de Husserl/Heidegger nas suas críticas à IA. Emboramuitos praticantes da IA continuem desenvolvendo a agenda racional/lógica (também conhe-cida como GOFAI, de Good Old Fashioned AI , “a boa e velha IA”), um número crescente depesquisadores da área incorporaram estas críticas em novos e excitantes modelos de inteligên-cia. Mantendo a ênfase de Wittgenstein sobre as raízes antropológicas e culturais do conheci-mento, eles se voltaram, como inspiração, para modelos sociais de comportamento inteligen-te, algumas vezes chamados de “situados”.

Como exemplo de alternativa para uma abordagem baseada em lógica, os pesquisadores

da área de aprendizado conexionista (Seção 1.2.9 e Capítulo 10) retiraram a ênfase na lógicae no funcionamento da mente racional, num esforço para alcançar a inteligência modelando aarquitetura do cérebro físico. Os modelos neurais da inteligência enfatizam a habilidade docérebro em se adaptar ao mundo no qual ele está inserido, pela modificação dos relaciona-mentos entre neurônios individuais. Em vez de representar o conhecimento por sentenças ló-gicas explícitas, eles capturam o conhecimento implicitamente, como uma propriedade de pa-drões de relacionamentos.

Um outro modelo de inteligência baseado na biologia busca sua inspiração nos processospelos quais espécies inteiras se adaptam ao seu ambiente. Os trabalhos em vida artificial e emalgoritmos genéticos (Capítulo 11) aplicam os princípios da evolução biológica aos proble-mas de encontrar soluções para problemas difíceis. Estes programas não resolvem problemasraciocinando logicamente sobre eles; em vez disso, eles geram populações de soluções candi-datas competidoras e as forçam a evoluir para soluções melhores por um processo que imita

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 12/27

36 INTELIGÊNCIA ARTIFICIAL

a evolução biológica: soluções candidatas pobres tendem a se extinguir, enquanto que aque-las que se mostram mais promissoras em resolver um problema sobrevivem e se reproduzemconstruindo novas soluções, a partir de componentes dos seus pais bem-sucedidos.

Os sistemas sociais fornecem uma outra metáfora para a inteligência, uma vez que elesexibem comportamentos globais que os permitem resolver problemas que confundiriam qual-quer um de seus membros individuais. Por exemplo, embora nenhum indivíduo possa predi-

zer precisamente o número de pães que serão consumidos na cidade de Nova York num deter-minado dia, o sistema de padarias de Nova York como um todo realiza muito bem a tarefa demanter a cidade abastecida com pães, com o mínimo de desperdício. O mercado de ações fazum excelente trabalho em fixar os valores relativos de centenas de empresas, muito emboracada investidor individual tenha somente um conhecimento limitado sobre poucas empresas.Um último exemplo vem da ciência moderna. Indivíduos localizados em universidades, na in-dústria ou em instituições governamentais enfrentam problemas comuns. Problemas impor-tantes à sociedade como um todo são atacados e solucionados por agentes individuais agindoquase que independentemente, tendo conferências e revistas científicas como principaismeios de comunicação, embora o progresso, em muitos casos, também seja conduzido poragências de fomento.

Estes exemplos compartilham dois temas: primeiro, a visão da inteligência como enrai-zada na cultura e sociedade e, como conseqüência, emergente. O segundo, que a inteligênciaé o reflexo dos comportamentos coletivos de um grande número de indivíduos semi-autôno-mos muito simples que interagem entre si, ou agentes. Quer estes agentes sejam redes neurais,ou membros individuais de uma espécie, ou, ainda, uma única pessoa de uma sociedade, assuas interações produzem inteligência.

Quais são os grandes temas que justificam uma visão de inteligência emergente, orienta-da a agentes? Entre eles se incluem:

1 Agentes são autônomos ou semi-autônomos. Isto é, cada agente tem certas respon-

sabilidades na solução de problemas, com pouco ou nenhum conhecimento do queoutros agentes fazem ou de como o fazem. Cada agente realiza a sua parte inde-pendente da solução do problema e, ou produz um resultado (faz alguma coisa), ourelata os seus resultados para outros indivíduos da comunidade de agentes.

2 Os agentes são “situados”. Cada agente é sensível ao seu ambiente particular e(normalmente) não tem conhecimento do domínio completo de todos os agentes.Assim, o conhecimento de um agente é limitado às tarefas correntes: “o arquivoque estou processando” ou “a parede próxima a mim”, sem qualquer conhecimen-to do conjunto total de arquivos ou das restrições físicas da tarefa de solução deproblema.

3 Agentes são interativos. Isto significa que eles formam uma coleção de indivíduosque cooperam numa tarefa particular. Neste sentido, eles podem ser vistos comouma “sociedade” e, como na sociedade humana, o conhecimento, as habilidades eas responsabilidades, mesmo quando vistas como coletivas, estão distribuídas pe-la população de indivíduos.

4 A sociedade de agentes é estruturada. Na maioria das visões de solução de proble-mas orientada a agentes, cada indivíduo, embora tendo o seu ambiente e conjuntode habilidades particulares e únicas, precisa se coordenar com outros agentes paraa solução global do problema. Assim, uma solução final não será vista apenas co-

mo coletiva, mas, também, como cooperativa.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 13/27

IA:HISTÓRIA E APLICAÇÕES 37

5 Finalmente, o fenômeno da inteligência neste ambiente é “emergente”. Emboraagentes individuais sejam vistos como se possuíssem conjuntos de habilidades eresponsabilidades, o resultado cooperativo global da sociedade de agentes pode servisto como maior que a soma de suas contribuições individuais. A inteligência évista como um fenômeno que reside e emerge da sociedade e não apenas uma pro-priedade de um agente individual.

Com base nestas observações, definimos um agente como um elemento de uma socie-dade que pode perceber aspectos (freqüentemente limitados) de seu ambiente e afetá-lo,quer diretamente ou através da cooperação com outros agentes. A maioria das soluções in-teligentes requer uma variedade de agentes. Aí se incluem agentes de rotina, que simples-mente capturam e comunicam partes da informação; agentes de coordenação, que dão su-porte às interações entre outros agentes; agentes de busca, que examinam coleções de infor-mação e formam conceitos ou generalizações; e agentes de decisão, que podem tanto dis-parar tarefas como chegar a conclusões com base em informação e processamento limita-dos. Retomando uma definição mais antiga de inteligência, agentes podem ser vistos comomecanismos que suportam a tomada de decisão no contexto de recursos computacionais li-

mitados.Os requisitos principais para projetar e construir uma sociedade de agentes são:

1 estruturas para a representação da informação;

2 estratégias para busca através de soluções alternativas;

3 criação de arquiteturas que possam suportar a interação de agentes.

Os capítulos restantes deste livro, especialmente a Seção 6.4, incluem prescrições para a cons-trução de ferramentas de suporte para esta sociedade de agentes.

A nossa discussão preliminar sobre a possibilidade de uma teoria da inteligência auto-mática não teve a intenção de exagerar o progresso atingido na atualidade ou minimizar otrabalho que se encontra pela frente. Como enfatizamos ao longo de todo o texto, é impor-tante que tenhamos consciência das nossas limitações e que sejamos honestos acerca de nos-sos sucessos. Houve, por exemplo, resultados apenas limitados com programas dos quais sepode dizer, em qualquer sentido interessante, que “aprendem”. As nossas realizações na mo-delagem das complexidades semânticas de uma linguagem natural, como o inglês, tambémtêm sido modestas. Mesmo questões fundamentais, como a organização do conhecimento ouo completo gerenciamento da complexidade e correção de programas de computadores mui-to grandes (como grandes bases de conhecimento), requerem pesquisas adicionais conside-ráveis. Os sistemas baseados em conhecimento, embora tenham atingido sucesso notável doponto de vista da engenharia, ainda têm muitas limitações na qualidade e generalidade doseu raciocínio. Aqui se incluem a sua incapacidade de realizar raciocínio de bom senso ouem exibir conhecimento de uma realidade física rudimentar, por exemplo, como as coisasmudam com o tempo.

Mas devemos manter uma perspectiva razoável. É fácil subestimar as realizações da inte-ligência artificial quando encaramos honestamente o trabalho que nos resta. Na próxima se-ção, estabelecemos esta perspectiva através de uma visão geral de várias áreas da pesquisa edesenvolvimento em inteligência artificial.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 14/27

38 INTELIGÊNCIA ARTIFICIAL

1.2 UMA VISÃO GERAL DAS ÁREAS DE APLICAÇÃO DA IA

O Motor Analítico não tem pretensões de criar algo original. Ele pode fazer qualquer coisa, des-

de que saibamos como mandá-lo realizar.

ADA BYRON , Condessa de Lovelace

Desculpe-me, Dave; eu não posso deixá-lo fazer isto.

HAL 9000 em 2001: Uma Odisséia no Espaço, de Arthur C. Clarke

Retornamos agora ao nosso objetivo de definir inteligência artificial através de um exame dasambições e realizações dos pesquisadores da área. As duas preocupações fundamentais dospesquisadores em IA são representação de conhecimento e busca. A primeira trata do proble-ma de capturar numa linguagem formal, isto é, numa linguagem adequada para ser manipula-da em computador, toda a extensão de conhecimento necessário para um comportamento in-teligente. O Capítulo 2 introduz o cálculo de predicados como uma linguagem para descreveras propriedades e relacionamentos entre objetos em domínios de problemas que, para a suasolução, necessitam de raciocínio qualitativo, em vez de cálculos aritméticos. Em capítulos

posteriores (6, 7 e 8), são discutidas as linguagens que a inteligência artificial desenvolveu pa-ra representar as ambigüidades e complexidades de áreas como raciocínio de senso comum ecompreensão de linguagem natural. Os Capítulos 14 e 15 demonstram o uso de LISP e PRO-LOG para implementar essas representações.

Busca é uma técnica de solução de problemas que explora sistematicamente o espaço deestados do problema, isto é, os estágios sucessivos e alternativos no processo de solução doproblema. Exemplos de estados de um problema incluem as diferentes configurações do ta-buleiro num jogo ou os passos intermediários num processo de raciocínio. Este espaço de so-luções alternativas é, então, explorado através de uma busca para se encontrar uma respostafinal. Newell e Simon (1976) propuseram que esta é a base essencial da solução de problemas

por seres humanos. De fato, quando um jogador de xadrez examina os efeitos de diferentesmovimentos ou um médico considera uma série de diagnósticos alternativos, eles estão reali-zando uma busca entre diferentes alternativas. As implicações deste modelo e técnicas parasua implementação são discutidas nos Capítulos 3, 4, 5 e 16.

Como a maioria das ciências, a IA é composta de uma série de disciplinas que, ao mesmotempo em que compartilham uma abordagem essencial para a solução de problemas, estãopreocupadas com aplicações diferentes. Nesta seção, apresentamos algumas das mais impor-tantes áreas de aplicação e suas contribuições para a inteligência artificial como um todo.

1.2.1 Jogos

Muitas das pesquisas iniciais em busca em espaço de estados foram realizadas utilizando jo-gos de tabuleiro comuns, como xadrez, damas e o jogo-dos-15. Além do seu apelo intelectualinerente, os jogos de tabuleiro têm certas propriedades que os tornaram objetos de estudoideais para estes trabalhos iniciais. A maioria dos jogos utiliza um conjunto bem definido deregras: isto faz com que seja fácil gerar o espaço de busca e libera o pesquisador de muitas dasambigüidades e complexidades inerentes a problemas menos estruturados. As configuraçõesdo tabuleiro usadas nestes jogos são facilmente representáveis num computador, não reque-rendo o formalismo complexo necessário para capturar as sutilezas semânticas de domíniosde problemas mais complexos. Como os jogos podem ser praticados facilmente, o teste deprogramas de jogos não apresenta nenhum ônus financeiro ou ético. Nos Capítulos 3 e 4, é

apresentada a busca em espaço de estados, o paradigma que serve de base na maioria das pes-quisas em jogos.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 15/27

IA:HISTÓRIA E APLICAÇÕES 39

Os jogos podem gerar espaços de busca extremamente grandes. Eles podem ser grandese complexos o suficiente para necessitarem técnicas poderosas para determinar quais alterna-tivas devem ser exploradas no espaço do problema. Estas técnicas são chamadas de heurísti-cas e constituem uma área importante da pesquisa em IA. Uma heurística é uma estratégiaútil, mas potencialmente falível, como, por exemplo, checar para assegurar que um equipa-mento que não está respondendo esteja ligado na tomada, antes de admitir que ele esteja que-

brado, ou ainda, rocar, a fim de proteger o próprio rei da captura numa partida de xadrez. Mui-to do que chamamos de inteligência parece estar relacionado com as heurísticas usadas pelosseres humanos para resolver problemas.

Como a maioria de nós tem alguma experiência com esses jogos simples, é possível pla-nejar e testar a eficácia de nossas próprias heurísticas. Não precisamos consultar um especia-lista como em algumas áreas restritas, por exemplo, medicina e a matemática (xadrez é umaexceção óbvia a esta regra). Por essas razões, os jogos proporcionam um domínio rico para oestudo da busca heurística. O Capítulo 4 introduz a noção de heurística usando esses jogossimples; o Capítulo 7 estende a sua aplicação a sistemas especialistas. Os programas de jogos,apesar da sua simplicidade, apresentam seus próprios desafios, incluindo um adversário cujosmovimentos não podem ser antecipados deterministicamente (Capítulo 8). A presença de umadversário complica ainda mais a concepção de programas de jogos, adicionando um elemen-to de imprevisibilidade e a necessidade de se considerar fatores tanto psicológicos como táti-cos na estratégia do jogo.

1.1.1 Raciocínio Automático e Prova Automática de Teoremas

Podemos afirmar que a prova automática de teoremas é o ramo mais antigo da inteligência ar-tificial, sendo possível traçar as suas raízes passando pelo Teorista Lógico, de Newell e Simon(Newell e Simon, 1963a), bem como pelo seu Solucionador Geral de Problemas (Newell eSimon, 1963b), até às suas origens nos esforços de Russell e Whitehead para tratar toda a ma-

temática como uma derivação puramente formal de teoremas, a partir de axiomas básicos. Dequalquer forma, este tem sido certamente um dos ramos mais frutíferos da IA. A pesquisa emprova automática de teoremas foi responsável por muitos trabalhos iniciais na formalizaçãode algoritmos de busca e no desenvolvimento de linguagens de representação formais como ocálculo de predicados (Capítulo 2) e a linguagem de programação em lógica PROLOG (Ca-pítulo 14).

Muito do apelo da prova automática de teoremas reside no rigor e na generalidade da ló-gica. Por ser um sistema formal, a lógica presta-se bem para ser automatizada. Uma ampla va-riedade de problemas pode ser atacada representando a descrição do problema e a informaçãosecundária relevante como axiomas lógicos e tratando casos do problema como teoremas a se-

rem provados. Esta abordagem é a base dos trabalhos em prova automática de teoremas e emsistemas de raciocínio matemático (Capítulo 12).Infelizmente, os esforços iniciais para criar provadores de teoremas fracassaram em de-

senvolver um sistema que pudesse solucionar, de modo consistente, problemas complicados.Isto se deveu à habilidade de qualquer sistema lógico razoavelmente complexo de gerar umnúmero infinito de teoremas prováveis: sem técnicas (heurísticas) para guiar a sua busca, osprovadores automáticos de teoremas provavam um grande número de teoremas irrelevantesantes de encontrar o teorema correto. Em resposta a esta ineficiência, muitos pesquisadoresafirmam que métodos sintáticos, puramente formais para guiar a busca, são inerentemente in-capazes de lidar com um espaço tão grande e que a única alternativa é confiar nas estratégiasad hoc informais que os seres humanos parecem utilizar para resolver problemas. Esta é a es-tratégia implícita no desenvolvimento de sistemas especialistas (Capítulo 7) e que provou seradequada.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 16/27

40 INTELIGÊNCIA ARTIFICIAL

Além disso, o apelo do raciocínio baseado em lógica matemática formal é forte demaispara ser ignorado. Muitos problemas importantes, como o projeto e a verificação de circuitoslógicos, a verificação da correção de programas computacionais e o controle de sistemas com-plexos, parecem corresponder a esta abordagem. De fato, a comunidade de prova de teoremastem obtido sucesso em conceber heurísticas poderosas para a solução de problemas que de-pendem apenas de uma estimativa da forma sintática de uma expressão lógica, e, como resul-

tado, capazes de reduzir a complexidade do espaço de busca sem recorrer a técnicas ad hocusadas pela maioria dos peritos humanos.Uma outra razão para o interesse continuado em provadores automáticos de teoremas é a

compreensão de que tais sistemas não precisam ser capazes de resolver independentementeproblemas extremamente complexos sem assistência humana. Muitos provadores de teoremasmodernos funcionam como assistentes inteligentes, liberando os seres humanos para realizaras tarefas mais exigentes de decomposição de um problema grande em subproblemas e paraconceber heurísticas de busca no espaço de provas possíveis. O provador de teoremas, então,realiza a tarefa mais simples, mas ainda assim exigente, de provar lemas, verificar pequenasconjecturas e completar os aspectos formais de uma prova delineada pelo seu assistente hu-mano (Boyer e Moore, 1979; Bundy, 1988; Veroff, 1997).

1.2.3 Sistemas Especialistas

Uma das mais importantes conclusões que foi tirada dos trabalhos iniciais em solução de pro-blemas foi a importância do conhecimento específico do domínio. Um médico, por exemplo,não é efetivo em diagnosticar uma doença apenas porque ele possui alguma habilidade inataem resolver problemas genéricos; ele é eficaz porque sabe muito sobre medicina. Da mesmaforma, um geólogo é eficaz em descobrir depósitos de minérios porque ele é capaz de aplicaruma grande quantidade de conhecimento teórico e empírico sobre geologia ao problema es-pecífico. O conhecimento especialista é uma combinação de um entendimento teórico do pro-

blema com uma coleção de regras heurísticas para resolver problemas, que a experiência de-monstrou ser efetiva no domínio. Os sistemas especialistas são construídos através da extra-ção deste conhecimento de um especialista humano, codificando-o de uma forma que umcomputador possa aplicar a problemas similares.

Uma característica fundamental dos sistemas especialistas é que a sua estratégia para re-solver problemas é dependente do conhecimento de um especialista humano no domínio. Em-bora existam alguns programas onde o projetista é também a fonte do conhecimento do domí-nio, geralmente é muito mais provável que esses programas sejam um produto da colaboraçãoentre um especialista do domínio, como um médico, um químico, um geólogo ou um enge-nheiro, e um especialista em inteligência artificial. O especialista no domínio fornece o co-

nhecimento necessário do domínio do problema, tanto através de uma discussão geral dosseus métodos de resolução de problema como demonstrando estas habilidades num conjuntocuidadosamente escolhido de exemplos de problemas. O especialista em IA, ou engenheiro

do conhecimento, como freqüentemente são conhecidos os projetistas de sistemas especialis-tas, é responsável por implementar este conhecimento num programa que seja tanto efetivocomo aparentemente inteligente, do ponto de vista de seu comportamento. Uma vez que esteprograma esteja escrito, é necessário refinar a sua perícia através da apresentação de exemplosde problemas a resolver, sob supervisão crítica do especialista no domínio, e realizar quais-quer alterações necessárias no conhecimento do programa. Este processo é repetido até que oprograma atinja o nível desejado de desempenho.

Um dos sistemas mais antigos a explorar o conhecimento específico do domínio para asolução de problemas foi o DENDRAL, desenvolvido em Stanford no final dos anos 60(Lindsay et al., 1980). Este sistema foi projetado para inferir a estrutura de moléculas orgâni-

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 17/27

IA:HISTÓRIA E APLICAÇÕES 41

cas a partir de suas fórmulas químicas e de informações de espectrografia de massa das liga-ções químicas presentes nas moléculas. Como as moléculas orgânicas normalmente são mui-to grandes, o número de estruturas possíveis para estas moléculas tende a ser enorme. O DEN-DRAL trata o problema deste grande espaço de busca aplicando o conhecimento heurístico deespecialistas em química no problema de elucidação da estrutura. O método utilizado mos-trou-se muito efetivo, obtendo rotineiramente a estrutura correta entre milhões de possibilida-

des após algumas tentativas. A abordagem se mostrou tão bem-sucedida que, hoje em dia, sãousados programas descendentes daquele sistema em laboratórios químicos e farmacêuticosespalhados por todo o mundo.

Enquanto o DENDRAL foi um dos primeiros programas a usar efetivamente conheci-mento específico do domínio para alcançar o desempenho de especialistas na resolução doproblema, o MYCIN estabeleceu a metodologia dos sistemas especialistas contemporâneos(Buchanan e Shortliff, 1984). O MYCIN utiliza conhecimento de especialistas médicos pa-ra diagnosticar e prescrever tratamento para meningite espinhal e infecções bacterianas dosangue.

Este programa, desenvolvido em Stanford em meados dos anos 70, foi um dos primeiros atratar os problemas do raciocínio com informações incertas ou incompletas. Ele fornecia ex-planações lógicas claras do seu raciocínio, utilizava uma estrutura de controle apropriada parao domínio específico do problema e identificava critérios para avaliar o seu desempenho de for-ma confiável. Muitas das técnicas de desenvolvimento de sistemas especialistas em uso atual-mente foram desenvolvidas originalmente no projeto MYCIN (Capítulo 7).

Outros sistemas especialistas clássicos são o programa PROSPECTOR, para determinara localização e o tipo prováveis de depósitos de minério com base em informação geológicasobre um sítio (Duda et al., 1979a, 1979b); o programa INTERNIST, para realizar diagnósti-cos na área da medicina interna, o Dipmeter Advisor, para interpretar os resultados de logs deperfuração de poços petrolíferos (Smith e Baker, 1983); e o XCON, para configurar compu-tadores VAX. O XCON foi desenvolvido em 1981 e, naquele tempo, todo computador VAX

vendido pela Digital Equipment Corporation era configurado por este software. Vários outrossistemas especialistas são atualmente aplicados para resolver problemas em áreas como a me-dicina, educação, negócios, projeto e ciência (Waterman, 1986; Durkin, 1994).

É interessante notar que a maioria dos sistemas especialistas foi escrita para domínioscom nível de perícia relativamente especializado. Estes domínios são geralmente bem estuda-dos e têm estratégias de solução de problemas claramente definidas. Problemas que depen-dem de uma noção de “senso comum”, definida de forma menos rígida, são muito mais difí-ceis de serem resolvidos por estes meios. Apesar das promessas dos sistemas especialistas, se-ria um erro superestimar a habilidade desta tecnologia. Entre as deficiências mais comuns en-contradas atualmente, estão:

1 Dificuldade em capturar conhecimento “profundo” do domínio do problema. NoMYCIN, por exemplo, falta conhecimento real da fisiologia humana. Ele não sabeo que ocorre com o sangue ou qual é a função da medula espinhal. Conta-se que,quando estava selecionando uma droga para o tratamento de meningite, o MYCINperguntou se o paciente estava grávido, mesmo sabendo que ele era do sexo mas-culino. Mesmo havendo dúvidas se isto realmente ocorreu, ou se é apenas folclo-re, isto ilustra a limitação potencial do conhecimento em sistemas especialistas.

2 Falta de robustez e flexibilidade. Se a um ser humano for apresentado um proble-ma que ele não consiga resolver imediatamente, ele geralmente pode realizar um

exame dos princípios fundamentais e chegar a uma estratégia para atacá-lo. Os sis-temas especialistas, em geral, não possuem esta habilidade.

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 18/27

42 INTELIGÊNCIA ARTIFICIAL

3 Inabilidade em fornecer explanações aprofundadas. Como os sistemas especialis-tas não têm um conhecimento profundo de seus domínios, as suas explanações sãogeralmente restritas a uma descrição dos passos que eles realizaram para encontrara solução. Normalmente, por exemplo, eles são incapazes de explicar “por que”adotaram uma certa abordagem.

4 Dificuldades na verificação. Embora a correção de qualquer sistema computacio-nal extenso seja difícil de se provar, os sistemas especialistas são particularmentedifíceis de serem verificados. Este é um problema sério, uma vez que a tecnologiados sistemas especialistas vem sendo utilizada em aplicações críticas, como o con-trole de tráfego aéreo, operação de reatores nucleares e sistemas de armamentos.

5 Pouca aprendizagem por experiência. Os sistemas especialistas atuais são artesa-nais; quando o sistema já se encontra desenvolvido, o seu desempenho não irá me-lhorar sem ajuda de seus programadores. Isto levanta severas dúvidas sobre a inte-ligência destes sistemas.

Apesar dessas limitações, os sistemas especialistas têm provado o seu valor em váriasaplicações importantes. Espera-se que estas limitações encorajem o estudante a se dedicar aeste importante ramo da ciência da computação. Os sistemas especialistas constituem um dosprincipais tópicos deste texto e são discutidos nos Capítulos 6 e 7.

1.2.4 Compreensão da Linguagem Natural e Modelagem Semântica

Um dos objetivos da inteligência artificial, que vem sendo perseguido há muito tempo, é acriação de programas que sejam capazes de entender e gerar a linguagem humana. A habili-dade em utilizar e compreender a linguagem natural não apenas parece ser um aspecto funda-mental da inteligência humana, mas também a sua automação teria um impacto inacreditável

sobre a facilidade de utilização e eficácia dos próprios computadores. Foram feitos grandesesforços no desenvolvimento de programas que compreendem a linguagem natural. Emboraestes programas tenham alcançado sucesso em contextos restritos, sistemas que possam usarlinguagem natural com a flexibilidade e a generalidade que caracterizam a fala humana aindaestão além das metodologias atuais.

Compreender a linguagem natural envolve muito mais do que simplesmente analisar sen-tenças, separando-as em suas partes individuais, e procurar estas palavras num dicionário. Acompreensão real depende de um extenso conhecimento do domínio do discurso e das expres-sões idiomáticas utilizadas naquele domínio, bem como da habilidade em aplicar conheci-mento contextual genérico para resolver omissões e ambigüidades que são parte usual da fa-

la humana.Considere, por exemplo, as dificuldades de se estabelecer uma conversação sobre beise-bol com um indivíduo que entende o inglês, mas não sabe nada sobre as regras, os jogadorese a história deste jogo. Será que esta pessoa poderia compreender o significado da sentença:“Sem ninguém no topo da nona e com uma corrida na segunda, o treinador tirou o seu reser-va do curral”? Muito embora cada uma das palavras na sentença possa ser compreendida in-dividualmente, esta sentença soaria incompreensível mesmo para uma pessoa muito inteligen-te que não fosse um fã do beisebol.

A tarefa de coletar e organizar este conhecimento de fundo, de forma que ele possa seraplicado à compreensão da linguagem, constitui o problema fundamental na automação da

compreensão da linguagem natural. Em resposta a esta necessidade, os pesquisadores desen-volveram muitas das técnicas para estruturar o significado semântico usado em toda a inteli-gência artificial (Capítulos 6, 7 e 13).

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 19/27

IA:HISTÓRIA E APLICAÇÕES 43

Devido à enorme quantidade de conhecimento necessária para a compreensão da lin-guagem natural, a maioria dos trabalhos é realizada em áreas de problemas especializadas.Um dos primeiros programas a explorar esta metodologia de “micromundo” foi o SHRD-LU, de Winograd, um sistema de linguagem natural que podia “conversar” sobre uma con-figuração simples de blocos de diferentes formas e cores (Winograd, 1973). O SHRDLUpodia responder a perguntas como “qual é a cor do bloco que está sobre o cubo azul?”, bem

como planejar ações como “coloque a pirâmide vermelha sobre o tijolo verde”. Problemasdeste tipo, envolvendo a descrição e manipulação de arranjos simples de blocos, têm apare-cido com freqüência surpreendente em pesquisas de IA e são conhecidos como problemasde “mundo de blocos”.

Apesar do sucesso do SHRDLU em conversar sobre arranjos de blocos, os seus métodosnão podem ser generalizados para além do mundo de blocos. As técnicas representacionaisusadas no programa eram simples demais para capturar, de uma maneira útil, a organizaçãosemântica de domínios mais ricos e complexos. Grande parte do trabalho atual em compreen-são da linguagem natural é devotada a encontrar formalismos representacionais que sejam ge-rais o suficiente para serem usados num amplo espectro de aplicações, mas também que seadaptem bem à estrutura específica de um dado domínio. Várias técnicas diferentes (a maio-ria das quais são extensões ou modificações de redes semânticas) são exploradas para estepropósito e são usadas no desenvolvimento de programas que podem compreender a lingua-gem natural em domínios de conhecimento restritos, mas interessantes. Por fim, em pesqui-sas recentes (Marcus, 1980; Manning e Schutze, 1999; Jurafsky e Martin, 2000), modelos es-tocásticos, descrevendo como conjuntos de palavras “co-ocorrem” no uso da linguagem, sãoempregados para caracterizar tanto a sintaxe como a semântica. Entretanto, a compreensão to-tal da linguagem permanece além do estado da arte atual.

1.2.5 Modelando o Desempenho Humano

Embora grande parte da discussão acima utilize a inteligência humana como um ponto de re-ferência ao considerar a inteligência artificial, os programas discutidos não seguem o modelode organização da mente humana. De fato, muitos programas de IA são concebidos para re-solver algum problema útil, sem levar em consideração as suas similaridades com a arquite-tura mental humana. Mesmo os sistemas especialistas, que extraem muito do seu conheci-mento de especialistas humanos, não procuram realmente simular os processos mentais inter-nos humanos de solução de problemas. Se o desempenho é o único critério pelo qual um sis-tema é julgado, pode ser que não haja muito motivo para simular os métodos humanos de so-lução de problemas; de fato, os programas que utilizam abordagens não humanas para resol-ver problemas são, freqüentemente, mais bem-sucedidos que os seus correspondentes huma-

nos. Ainda assim, o projeto de sistemas que modelam explicitamente algum aspecto do de-sempenho humano tem sido uma área fértil de pesquisa, tanto em inteligência artificial comoem psicologia.

A modelagem do desempenho humano, além de proporcionar à IA grande parte de suametodologia básica, tem se mostrado uma ferramenta poderosa para formular e testar teoriasda cognição humana. As metodologias para solução de problemas, desenvolvidas por cientis-tas da computação, forneceram aos psicólogos uma nova metáfora para explorar a mente hu-mana. Em vez de formular teorias da cognição na linguagem vaga usada nas pesquisas ini-ciais, ou de abandonar o problema de descrever completamente os processos internos da men-te humana (como sugerido pelos behavioristas), muitos psicólogos adotaram a linguagem e ateoria da ciência da computação para formular modelos de inteligência humana. Estas técni-cas não apenas fornecem um novo vocabulário para descrever a inteligência humana, mastambém as implementações computacionais destas teorias oferecem aos psicólogos umaoportunidade de testar empiricamente, criticar e refinar as suas idéias (Luger, 1994). Uma dis-cussão mais aprofundada das relações entre a inteligência artificial e os esforços para com-

8/4/2019 Capitulo01_Luger

http://slidepdf.com/reader/full/capitulo01luger 20/27

44 INTELIGÊNCIA ARTIFICIAL

preender a inteligência humana pode ser encontrada em todo este livro, sendo resumida noCapítulo 16.

1.2.6 Planejamento e Robótica

A pesquisa em planejamento começou como um esforço para projetar robôs que pudessem

realizar as suas tarefas com algum grau de flexibilidade e sensibilidade em relação ao mundoexterno. Em suma, planejamento pressupõe um robô que seja capaz de realizar certas açõesatômicas. Ele procura encontrar uma seqüência destas ações que realize alguma tarefa de al-to nível, como se mover através de uma sala com vários obstáculos.

Planejamento é um problema difícil por uma série de razões, entre as quais o tamanho doespaço de seqüências possíveis de movimentos. Mesmo um robô extremamente simples é ca-paz de gerar um vasto número de seqüências de movimentos potenciais. Imagine, por exem-plo, um robô que pode se mover para frente, para trás, para a direita ou para a esquerda, e con-sidere de quantas maneiras diferentes o robô pode se mover numa sala. Assuma, também, quehaja obstáculos na sala e que o robô deva selecionar um caminho que desvie destes obstácu-los de uma forma eficiente. Desenvolver um programa que possa descobrir de modo inteligen-te o melhor caminho sob estas circunstâncias, sem ser sobrepujado pelo número enorme depossibilidades, requer técnicas sofisticadas para representar conhecimento espacial e contro-lar a busca através de ambientes possíveis.

Um dos métodos que os humanos usam para planejamento é a decomposição hierárqui-

ca do problema. Se você estiver planejando uma viagem a Londres, geralmente tratará sepa-radamente dos problemas de organizar o vôo, chegar ao aeroporto, fazer as conexões aéreas efazer o traslado em Londres, apesar de que eles sejam parte de um plano global maior. Cadaum destes problemas pode ser ainda decomposto em subproblemas menores, como encontrarum mapa da cidade, entender o sistema de metrô e encontrar um pub adequado. Esta aborda-gem não apenas restringe efetivamente o tamanho do espaço que deve ser buscado, mas tam-

bém permite armazenar os subplanos freqüentemente usados para serem utilizados no futuro.Diferentemente dos seres humanos, que planejam sem grande esforço, o desenvolvimen-

to de programas de computador que façam o mesmo é um grande desafio. Uma tarefa aparen-temente simples, como decompor um problema em subproblemas independentes, na verdaderequer heurísticas sofisticadas e conhecimento extensivo sobre o domínio do planejamento.Determinar quais subplanos devem ser armazenados e como eles podem ser generalizados pa-ra uso futuro é, também, um problema difícil.

Um robô dificilmente seria considerado inteligente se executasse cegamente uma seqüên-cia de ações sem responder a alterações no ambiente ou se não fosse capaz de detectar e cor-rigir erros no seu plano original. Normalmente, um robô precisa formular um plano com ba-