IFAM’s - Mem orias Associativas Baseadas no Aprendizado ...valle/PDFfiles/cbrn05_slides.pdf ·...

Transcript of IFAM’s - Mem orias Associativas Baseadas no Aprendizado ...valle/PDFfiles/cbrn05_slides.pdf ·...

IFAM’s - Memorias Associativas Baseadas

no Aprendizado Nebuloso Implicativo

Marcos Eduardo Valle ([email protected])Peter Sussner ([email protected])

19 de Outubro de 2005

Cronograma da Apresentacao:

1. Redes Neurais Nebulosas,

2. Aprendizado Nebuloso Implicativo,

3. Memorias Associativas Nebulosas Implicativas (IFAMs)

4. Exemplo - Armazenamento de Padroes,

5. Aplicacao - Problema de Predicao,

6. Relacao entre as IFAM’s, Memorias Associativas Morfologicas

e a Memoria Associativa de Wang-Lu,

7. Conclusao.

1

Modelo Neural...

Neuronios logicos de Pedrycz com limiar:

yi =n∨

j=1

(

wij txj

)

∨ θi , para i = 1,2, . . . , m .

ou

yi =n∧

j=1

(

mij s xj

)

∧ ϑi , para i = 1,2, . . . , m .

Entradas: x1, x2, . . . , xn,

Pesos Sinapticos: wij e mij,

Limiar (threshold): θi e ϑi,

Saıdas: y1, . . . , ym.

∨

representa o maximo e t uma t-norma,∧

representa o mınimo e s e uma s-norma.

2

Rede Neural Nebulosa (RNN)...

Rede neural nebulosa progressiva de camada unica com m neuronios:

y = (W ◦ x) ∨ θ,

e

y = (M • x) ∧ ϑ,

Vetor de entrada: x ∈ [0,1]n,

Matriz dos pesos sinapticos: W, M ∈ [0,1]m×n,

Vetor de limiar (threshold): θ, ϑ ∈ [0,1]m,

Vetor de saıdas: y ∈ [0,1]m.

◦ representa composicao max-t,

• representa composicao min-s.

3

Relacao de Dualidade...

Relacao de dualidade entre ◦ e •:

A • B = A ◦ B,

Onde R ∈ [0,1]m×n e a negacao de R ∈ [0,1]m×n dada por:

rij = 1 − rij.

Conclusao:

(M • x) ∧ ϑ = (M • x) ∨ ϑ =(

M ◦ x)

∨ ϑ

Vamos considerar somente RNN’s descritas pela composicao ◦.

4

Postulado de Hebb...

A variacao do peso de uma conexao sinaptica depende de ambas

ativacoes pre-sinaptica (entrada) e pos-sinaptica (saıda).

∆wij = F (xj, yi), (Haykin)

5

Aprendizado Nebuloso Implicativo...

Definimos:

∆wij =(

xj ⇒ yi

)

,

onde ⇒ e uma implicacao nebulosa.

Interpretacao: A variacao do pesos sinaptico e o grau de vera-

cidade da afirmacao: ”Se estımulo, entao resposta”.

6

Armazenando Varios Padroes...

Queremos treinar a rede com {(xξ,yξ) : ξ = 1, . . . , p}.

wij =(

x1j ⇒ y1

i

)

∧(

x2j ⇒ y2

i

)

∧ . . . ∧(

xpj ⇒ y

pi

)

=p∧

ξ=1

(

xξj ⇒ y

ξi

)

.

Notacao Matricial:

W = Y ~ XT ,

onde X = [x1, . . . ,xp] e Y = [y1, . . . ,yp].

7

R-implicacao...

R-implicacao associada a t (t-norma usada em ◦):

(x ⇒R y) = sup{z ∈ [0,1] : x t z ≤ y}.

Aprendizado nebuloso R-implicativo: W = Y ~R XT .

W obtida atraves do aprendizado nebuloso R-implicativo e a

solucao de

max{

W ∈ [0,1]m×n : W ◦ X ≤ Y}

.

Se existe W0 ∈ [0,1]m×n tal que W0◦X = Y entao W = Y ~RXT

e tal que W ◦ X = Y e W0 ≤ W .

8

Exemplos t-norma e R-implicacoes...

t-norma R-implicacao

x t y = x ∧ y x ⇒R y =

{

1, x ≤ y

y, x > y

x t y = x · y x ⇒R y = 1 ∧(

yx

)

x t y = 0 ∨ (x + y − 1) x ⇒R y = 1 ∧ (1 − x + y)

9

Memoria Associativa Nebulosa Implicativa(IFAM)

E uma rede neural nebulosa descrita pela equacao

y = (W ◦ x) ∨ θ

onde

W = Y ~R XT e θ =p∧

ξ=1

yξ

A implicacao usada em ~R e a R-implicacao associada a t-norma

de ◦.

10

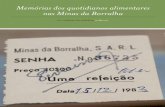

Exemplo da Literatura (Liu 1999)

Padroes de entrada e saıda:

ξ xξ

yξ

1 [0.5, 0.5, 0.4, 0.4, 0.3]T [0.5, 0.6, 0.3]T

2 [0.1, 0.3, 0.3, 0.4, 0.4]T [0.5, 0.6, 0.4]T

3 [0.8, 0.4, 0.6, 0.7, 0.4]T [0.6, 0.8, 0.4]T

4 [0.3, 0.4, 0.4, 0.3, 0.4]T [0.5, 0.6, 0.4]T

5 [0.6, 0.4, 0.7, 0.7, 0.5]T [0.7, 0.7, 0.5]T

6 [0.1, 0.1, 0.2, 0.2, 0.1]T [0.5, 0.6, 0.3]T

7 [0.7, 0.2, 0.4, 0.3, 0.2]T [0.5, 0.7, 0.3]T

8 [0.8, 0.4, 0.3, 0.4, 0.2]T [0.5, 0.8, 0.3]T

11

IFAM de Lukasiewicz

Matriz dos pesos sinapticos:

WLukasiewicz =

0.7 1.0 1.0 0.9 1.01.0 1.0 1.0 1.0 1.00.5 1.0 0.8 0.7 1.0

,

e o vetor de limiar

θ =[

0.5 0.6 0.3]T

.

12

Capacidade absoluta de armazenamento

Modelo Cap. Abs. de Arm.

Max-min FAM com limiar 8IFAM de Lukasiewicz 8

IFAM de Godel 8IFAM de Goguen 8FAM de Junbo 4

M.A. de Wang e Lu 4FAM de Kosko 1

GFAM de Lukasiewicz 0

Podemos mostrar que o desempenho da IFAM de Godel e no

mınimo tao bom quanto o desempenho da Max-mim FAM com

limiar.

13

Aplicacao das IFAM’s como Sistema deRegras Nebulosas

As memorias associativas nebulosas podem representar sistemas

de regras nebulosas onde armazenamos regras da forma SE-

ENTAO.

Aplicacao: Previsao de mao-de-obra requerida nas industrias

metalurgicas do estado Bengal do Oeste na India.

14

Definimos 5 variaveis linguısticas A1, A2, . . . , A5 e sentencas como

“Se a mao-de-obra requerida no ano n e Ai, entao a mao-de-

obra requerida no n + 1 e Aj”.

Obtemos um conjunto de pares de entrada e saıda que serao

armazenados numa memoria associativa nebulosa.

A estimativa da mao-de-obra requerida no ano n + 1 e:

An+1 = (W ◦ An) ∨ θ ,

onde An e a mao-de-obra requerida no ano n e ◦ e a composicao

max-t.

15

Previsao de mao-de-obra estimada:

1984 1986 1988 1990 1992 1994 19961100

1200

1300

1400

1500

1600

1700

1800

YEAR

MAN

POW

ER

Valor AtualIFAM Goguen e M.A. Wang−LuIFAM Godel e Max−min FAM LimiarKosko FAM e GFAMIFAM LukasiewiczARIMA1ARIMA2

16

Erro medio na previsao de mao-de-obra:

Metodo Erro medio

IFAM de Lukasiewcz 2.29%FAM de Kosko 2.67%

GFAM de Lukasiewicz 2.67%IFAM de Godel 2.73%

Max-min FAM com limiar 2.73%IFAM de Goguen 2.99%

M.A. de Wang e Lu 2.99%ARIMA2 5.48%ARIMA1 9.79%

17

IFAM’s e as Memorias AssociativasMorfologicas

Relacao entre a IFAM de Lukasiewicz e as memorias associativas

morfologicas:

W = (WXY ∧ 0) + 1,

(W ◦ x) ∨ θ = [(WXY ∧ 0) ∨� x] ∨ θ.

18

IFAM’s e a Memoria Associativa deWang-Lu

A fase de recordacao da IFAM de Goguen e da memoria associ-

ativa de Wang e Lu sao identicas exceto pelo vetor limiar usado

na IFAM.

A diferenca entre estes dois modelos esta na fase de armazena-

mento:

WGG = WprodXY ∧ 1.

Importante: WGG ∈ [0,1]m×n enquanto que WprodXY ∈ (R≥0

∞ )m×n.

Logo, um padrao recordado pela a memoria associativa (mor-

fologica nebulosa) de Wang e Lu pode nao ser nebuloso.

19

Conclusao:

• IFAMs sao RNN treinadas usando o aprendizado nebuloso

R-implicativo.

Exemplos: IFAM de Lukasiewicz, IFAM de Godel e IFAM de

Goguen.

• Capacidade Absoluta de Armazenamento das IFAM’s e me-

lhor que a FAM Kosko e a FAM Generalizada de Chung-Lee.

• O desempenho da IFAM de Godel e no mınimo tao bom

quanto o desempenho da Max-mim FAM com limiar de Liu.

• IFAMs podem ser usadas como sistemas de regras nebulo-

sas.

20

• IFAM’s podem ser utilizadas em problemas da predicao.

IFAM de Lukasiewicz apresentou os melhor resultado.

Falta ainda conduzir pesquisas mais profundas sobre a uti-

lizacao das IFAMs como aproximadores de funcoes!

• Mostramos que a IFAM de Lukasiewicz e as memorias as-

sociativas morfologicas estao fortemente relacionadas se as

memorias fundamentais forem conjuntos nebulosos.

Uma relacao semelhente foi mostrada para IFAM de Goguen

e a memoria associativa de Wang e Lu.

• Falta conduzir pesquisas sobre a escolha da t-norma e da

R-implicacao utilizada da IFAM para um dado problema.