MACHINE LEARNING NA MELHORIA DE PROCESSOS INTERNOS ... · dos requisitos necessários à obtenção...

Transcript of MACHINE LEARNING NA MELHORIA DE PROCESSOS INTERNOS ... · dos requisitos necessários à obtenção...

1

MACHINE LEARNING NA

MELHORIA DE PROCESSOS INTERNOS:

ESTUDOS DE CASO NA INDÚSTRIA DE VAREJO

BRASILEIRA

Flora Mello Quintão Mateus

Mariana de Carvalho Mendonça

Projeto de Graduação apresentado ao Curso de

Engenharia de Produção da Escola Politécnica,

Universidade Federal do Rio de Janeiro, como parte

dos requisitos necessários à obtenção do título de

Engenheiro.

Orientador: Renato Flórido Cameira

Rio de Janeiro

Julho de 2020

3

Mendonça, Mariana de Carvalho

Mateus, Flora Mello Quintão

Machine learning na melhoria de processos internos: estudos

de caso na indústria de varejo brasileira/ Flora Mello Quintão

Mateus e Mariana de Carvalho Mendonça - Rio de Janeiro:

UFRJ/ Escola Politécnica, 2020.

6, 98 p.: il.; 29,7 cm.

Orientador: Renato Flórido Cameira

Projeto de Graduação - UFRJ/ POLI/ Curso de Engenharia de

Produção, 2020.

Referências Bibliográficas: p.94-98.

1. Aplicações 2. Inteligência Artificial 3. Machine learning 4.

Varejo 5. Marketplace 6. Detecção de fraude 7. Cancelamento

de planos 8. Software as a Service. I. Cameira, Renato Flórido

II. Universidade Federal do Rio de Janeiro, UFRJ, Curso de

Engenharia de Produção. III. Machine learning na melhoria

de processos internos: estudos de caso na indústria de varejo

brasileira.

4

AGRADECIMENTOS - FLORA

Gostaria de destacar que este projeto, assim como a minha formação no melhor curso

de engenharia de produção do Brasil (com muito orgulho de dizer!), foi uma realização não só

minha, mas também, indiretamente, da minha família. Agradeço à minha mãe Tereza e ao meu

pai Flávio por serem meus incentivadores desde sempre, pela educação, valores e amor que me

deram e que me fizeram chegar até aqui. Também agradeço às minhas avós Ludia e Cleyde

pelo apoio e ensinamentos durante a minha vida.

Há também muitas pessoas que me ajudaram a iniciar essa jornada na UFRJ e outras

que fizeram dela a melhor possível.

Agradeço à minha ex-professora Margaret pelo trabalho voluntário nas aulas de redação

para o ENEM que foi um pilar para que eu conseguisse a vaga neste curso. Com certeza sua

paixão pela profissão e pela missão em ajudar seus alunos a realizarem seus sonhos a fazem

uma pessoa extraordinária.

Muito obrigada também às minhas primas Camilla e Maria de Lourdes por todo apoio

que me ajudou a permanecer no curso.

Também agradeço ao corpo docente do DEI UFRJ que se esforça todos os dias para a

manter e renovar a excelência de ensino do curso de engenharia de produção. Um

agradecimento especial ao orientador deste trabalho, Renato Cameira, por todo seu empenho e

carinho durante as orientações deste projeto, mas também por ser um exemplo de dedicação às

aulas e à UFRJ. Além disso, agradeço também os funcionários das secretarias e da limpeza que

suportaram a realização das atividades na universidade.

Fundamentais ao meu proveito do curso e à minha feliz jornada até aqui, agradeço aos

meus amigos desde o início - Ligia Garcia, Mariana Campista, Matheus Xavier, Gustavo

Amorim e Alexandre Borges. Mas especialmente à Mariana, minha parceira neste trabalho, nos

estudos para as provas, nas conversas de carreira, nas conversas de bar e em muitos momentos

que a vida trouxe e irá trazer.

Assim, finalizo meus genuínos agradecimentos a todos estes que participaram da minha

formação como Engenheira de Produção pela Universidade Federal do Rio de Janeiro. O

trabalho será árduo e prazeroso para fazer jus a tudo que me foi proporcionado.

5

AGRADECIMENTOS - MARIANA

Em primeiro lugar, gostaria de agradecer aos meus pais, João Batista e Maria Cristina,

que sempre se dedicaram para que eu tivesse boa índole e acesso à educação de qualidade, além

da minha cachorra Princesa, que ficava no meu pé (literalmente) enquanto eu estudava.

Agradeço também de maneira especial ao meu irmão, João Vitor, que me motivou a

seguir carreira na área de Engenharia de Produção com todo seu entusiasmo ao falar do curso e

das aplicações que enxergava no estágio, além da minha cunhada Ivna que sempre me transmite

calma e paciência.

Não poderia deixar de agradecer ao meu parceiro de vida João Filho, que me

acompanhou por todo período de elaboração deste trabalho, me motivando tanto neste projeto

como em todos os outros que eu resolvo embarcar, com muita leveza e sorriso no rosto.

Não menos importante, também gostaria de agradecer aos meus colegas de curso,

especialmente minha dupla de Projeto Final, Flora, que desde o primeiro período esteve comigo,

seja estudando para as infinitas provas unificadas ou para aliviar o estresse pós-trabalho em

uma roda de samba ou em um barzinho. Obrigada àqueles que me acompanharam de perto

nessa trajetória, Rubens Correa, Matheus Xavier, Luiza Amante, Raphael Duarte, Marta Haik,

Sabrina Adegas, Carolina Kiss, Rafael Marinho, Daniel Flórido, Eduardo Gouveia, Arthur

Vidigal, Polyana Benfeita, entre outros.

Agradeço bastante aos professores do curso de Engenharia de Produção, especialmente

ao orientador deste trabalho Renato Cameira, por toda atenção e suporte tanto nas aulas quanto

na elaboração deste trabalho e ao professor Vinícius Cardoso pelos ensinamentos ao longo das

orientações de Iniciação Científica.

Por fim, agradeço ao Colégio Pedro II, que me ensinou valores e me permitiu fazer parte

de uma universidade de excelência.

6

Resumo do Projeto de Graduação apresentado à Escola Politécnica/ UFRJ como parte dos

requisitos necessários para a obtenção do grau de Engenheiro de Produção.

MACHINE LEARNING NA MELHORIA DE PROCESSOS INTERNOS: ESTUDOS DE

CASO NA INDÚSTRIA DE VAREJO BRASILEIRA

Flora Mello Quintão Mateus

Mariana de Carvalho Mendonça

Julho de 2020

Orientador: Renato Flórido Cameira

Curso: Engenharia de Produção

Resumo:

A transformação digital e tecnologia impactam o modelo de negócio das organizações.

O presente trabalho aborda as principais tecnologias cognitivas, com foco e aprofundamento

mais específico no machine learning no uso de algoritmos que agregam valor e otimizam os

processos em uma empresa da indústria de varejo no ramo de marketplace. O estudo foi

aprofundado na área de Trust&Safety com o modelo de detecção de fraude, e na área Comercial

com o modelo de previsão de cancelamento de planos. Como resultado deste trabalho, as

análises dos estudos de caso percorrem a definição do problema de negócio, a construção do

modelo e por fim, a análise crítica da implementação, com base no referencial teórico.

Palavras-chave: Aplicações, Inteligência Artificial, Machine Learning, Varejo, Marketplace,

Detecção de fraude, Cancelamento de planos, Software as a Service.

7

Abstract of Undergraduate Project presented to POLI/UFRJ as a partial fulfillment of the

requirements for the degree of Industrial Engineer.

MACHINE LEARNING TO IMPROVE INTERNAL PROCESSES: CASE STUDIES IN

THE BRAZILIAN RETAIL INDUSTRY

Flora Mello Quintão Mateus

Mariana de Carvalho Mendonça

August 2020

Advisor: Renato Flórido Cameira

Course: Industrial Engineering

Abstract:

The digital transformation and technology impact the business model of organizations.

The present work addresses the main cognitive technologies, with a more specific focus on

machine learning algorithms that add value and optimize processes in a retail industry company

within the marketplace sector. The study was developed in the Trust & Safety area with the

fraud detection model, and in the Commercial area with the model of plan cancellation

prediction. As a result of this work, the analysis of the case studies goes through the definition

of the business problem, the model construction and finally, the critical analysis of the

implementation, based on the theoretical frame of reference.

Keywords: Applications, Artificial Intelligence, Machine Learning, Retail, Marketplace; Fraud

detection; Plan cancelation; Software as a Service.

8

SUMÁRIO

1. INTRODUÇÃO 13

1.1 Contextualização 13

1.2 Motivações e Premissas 14

1.3 Objetivos 15

1.3.1 Objetivo geral 15

1.3.2 Objetivos específicos 15

1.4 Estrutura do trabalho 16

1.4.1 Descrição dos capítulos 16

1.4.2 Delimitações 17

1.4.3 Limitações 17

2. METODOLOGIA DA PESQUISA 18

3. TRANSFORMAÇÃO DIGITAL E INDÚSTRIA 4.0 20

3.1 Conceito e panorama histórico 20

3.2 Estratégia de transformação digital 21

3.3 Categorias de tecnologias 25

3.3.1 Resultados financeiros e tendências de crescimento 25

3.3.2 Conceitos 28

4. MACHINE LEARNING 37

4.1 Conceito 37

4.2 Técnicas 38

4.3 Algoritmos 40

4.4 Processo de construção de um modelo de machine learning 42

4.4.1 Definição do problema de negócio 43

4.4.2 Análise exploratória 43

4.4.3 Criação da amostra de desenvolvimento do modelo 45

4.4.4 Organização de dados 46

4.4.5 Pré-processamento da base de dados 46

4.4.6 Construção do modelo 49

4.4.7 Teste do modelo 52

4.4.8 Definição das regras de decisão 53

4.5 Operacionalização do modelo na organização 55

5. MACHINE LEARNING NA INDÚSTRIA DO VAREJO 57

5.1 Marketplace: um recorte da indústria do varejo 57

9

5.2 Aplicações do machine learning no setor 62

6. ESTUDOS DE CASO 65

6.1 Caracterização da empresa 65

6.1.1 A empresa 65

6.1.2 Áreas de estudo 66

6.1.3 Levantamento de informações 67

6.2 Cancelamento de planos 68

6.2.1 Contexto 68

6.2.2 Construção do modelo 69

6.2.3 Análise crítica 71

6.3 Identificação de fraudes no chat 75

6.3.1 Contexto 75

6.3.1 Construção do modelo 75

6.3.2 Análise crítica 89

7. CONSIDERAÇÕES FINAIS 94

8. REFERÊNCIAS BIBLIOGRÁFICAS 97

9. APÊNDICE – CARACTERÍSTICAS DOS PRINCIPAIS ALGORITMOS DE

MACHINE LEARNING 103

10

LISTA DE FIGURAS

Figura 1: Contexto histórico das revoluções industriais ........................................................... 21

Figura 2: A pirâmide da transformação digital ......................................................................... 22

Figura 3: Quadro de direcionadores de investimento de acordo com habilitadores de eficiência

e de crescimento ....................................................................................................................... 23

Figura 4: Modelo de Customer-centric .................................................................................... 24

Figura 5: Produtividade e crescimento por tipo de tecnologia ................................................. 26

Figura 6: Produtividade por classe industrial ........................................................................... 26

Figura 7: Produtividade (EBITDA por funcionários) companhias líderes vs. seguidoras ....... 27

Figura 8: Alocação % de capital digital das organizações de 2017 a 2019 por objetivo ......... 28

Figura 9: Quadro de classificação de tecnologias por tipos de objetivos estratégicos ............. 29

Figura 10: A indústria 4.0 nos processos corporativos ............................................................. 30

Figura 11: Radar digital com habilitadores e aplicações .......................................................... 32

Figura 12: Evolução histórica dos sensores 1.0 aos sensores inteligentes ............................... 34

Figura 13: Técnicas de Machine learning por categorias. ........................................................ 38

Figura 14: Quadro Perguntas e fatores de análise para escolha de um algoritmo. ................... 41

Figura 15: Etapas do desenvolvimento de um modelo genérico de machine learning ............ 42

Figura 16: Quadro de boas práticas recomendadas na Análise exploratória ............................ 43

Figura 17: Quadro de práticas recomendadas para desafios comuns de aprendizado de máquina

.................................................................................................................................................. 45

Figura 18: Divisão da amostra de desenvolvimento de um modelo de machine learning

supervisionado .......................................................................................................................... 50

Figura 19: Exemplo de código de parte da construção de um modelo ..................................... 51

Figura 20: Exemplo de uma matriz de confusão ...................................................................... 52

Figura 21: Exemplo de um gráfico ROC .................................................................................. 54

Figura 22: Exemplo de gráfico precision-recall....................................................................... 54

Figura 23: Quadro dos tipos de marketplace e respectivas descrições ..................................... 58

Figura 24: Faturamento de marketplace 2015 a 2017 .............................................................. 59

Figura 25: Evolução dos consumidores .................................................................................... 59

Figura 26: Gráfico de quantidade e variação de vendedores nos marketplaces de setembro de

2017 a setembro de 2018 .......................................................................................................... 60

Figura 27: Gráfico de concentração de sellers por departamento nos marketplaces de setembro

de 2017 a setembro de 2018 ..................................................................................................... 61

Figura 28: Gráfico de Ofertas 1P vs Ofertas 3P nos marketplaces de setembro de 2017 a

setembro de 2018 ...................................................................................................................... 61

Figura 29: Gráfico do percentual de cancelamento em relação aos dias da predição no mês de

Setembro/2019 .......................................................................................................................... 72

Figura 30: Gráfico do percentual de cancelamento em relação aos dias da predição no mês de

janeiro/2020 .............................................................................................................................. 73

Figura 31: Resultados do antigo modelo Chat Sense da área de Trust&Safety ........................ 77

11

Figura 32: Simulação de prevenção de denúncias efetivas de fraude pelo modelo Chat Sense,

média semanal .......................................................................................................................... 77

Figura 33: Tempo de processamento do modelo Chat Sense, em minutos .............................. 78

Figura 34: Roadmap planejado para a construção do Fraud Detector ..................................... 79

Figura 35: Denúncias de fraude semanal vs. tempo entre a mensagem e a denúncia .............. 80

Figura 36: Distribuição do tamanho das conversas idôneas ..................................................... 81

Figura 37: Distribuição do tamanho das conversas de fraude .................................................. 81

Figura 38: Análise visual do agrupamento de palavras por PCA ............................................. 83

Figura 39: Validação da configuração Unigrama-bigrama pelo algoritmo Logistic Regression

.................................................................................................................................................. 84

Figura 40: Validação da configuração Trigrama pelo algoritmo Naive Bayes ........................ 84

Figura 41: 1º Teste da configuração Unigrama-bigrama pelo algoritmo Logistic Regression. 85

Figura 42: 1º Teste da configuração Trigrama pelo algoritmo Naive Bayes ........................... 85

Figura 43: 2º Teste da configuração Unigrama-bigrama pelo algoritmo Logistic Regression. 85

Figura 44: 2º Teste da configuração Trigrama pelo algoritmo Naive Bayes ........................... 85

Figura 45: Gráfico de ROC da 1ª versão do Fraud detector .................................................... 86

Figura 46: Gráfico precisão vs. Threshold ............................................................................... 87

Figura 47: Série temporal semanal do volume de denúncias efetivas de fraude ...................... 89

Figura 48: Tempo de processamento do modelo Fraud Detector em milissegundos .............. 89

Figura 49: Roadmap realizado de construção do modelo Fraud Detector ............................... 92

Figura 50: Características dos principais algoritmos de Machine Learning .......................... 106

12

LISTA DE ABREVIATURAS E SIGLAS

CEI Customer Experience Index

BDA Big Data Analytics

CAGR Compound Annual Growth Rate

CPS Cyber Physical Systems

EBITDA Earnings before Interest, Taxes, Depreciation and Amortization

NIST Instituto Nacional Americano de Padrões e Tecnologia

IA Inteligência Artificial

IDC International Data Corporation

IoT Internet of Things

ML Machine Learning

LCD Liquid Cristal Display

NLP Natural Language Processing

B2B Business to Business

B2C Business to Consumer

C2C Consumer to Consumer

OKRs Objective and Key Results

PCA Principal Component Analysis

RPA Robotic Process Automation

SaaS Software as a Service

TI Tecnologia da Informação

TF-IDF Term Frequency-Inverse Document Frequency

13

1. INTRODUÇÃO

No primeiro capítulo é realizada uma breve contextualização do cenário de

transformação digital na economia global, com foco no mercado de varejo e a aplicação de

inteligência artificial e machine learning. Neste capítulo são ressaltadas as limitações e

delimitações do estudo, assim como os objetivos gerais, específicos e por fim, a estrutura do

trabalho.

1.1 Contextualização

Em um cenário competitivo e ágil, a necessidade de acompanhar e se adaptar às

transformações que surgem rapidamente tem sido um desafio para sobrevivência das

organizações. As tecnologias digitais, fundamentadas no computador, software e redes, não são

novas, mas estão causando rupturas significativas à terceira revolução industrial por sua

capacidade de integração e consequentemente pelo seu impacto nos meios de produção e na

economia global.

A quarta revolução industrial, apoiada fortemente em novas tecnologias habilitadoras,

diminuiu distância entre a informação e as pessoas e mudou a forma como os usuários interagem

entre si e de como as organizações aproximam a sociedade. Por esse motivo, os modelos e

processos de negócio passam por uma mudança radical para melhor aproveitar as tecnologias

emergentes e sua rápida expansão nas atividades humanas (PINÇON, 2017).

De acordo com Lorente (2016), as novas tecnologias podem gerar um impacto direto

sobre a experiência com o cliente. Otimizar canais e processos, procurar novos modelos e fluxos

de receita com base em exigências dos clientes e, em paralelo, transformar a estratégia da

organização. Nesse contexto, a melhoria de processos internos apresenta ganhos significativos.

Para compreender melhor as aplicações utilizadas pelo mercado para melhorar

processos internos, o presente trabalho apresenta uma revisão bibliográfica da literatura a

respeito das tecnologias cognitivas, com um aprofundamento no machine learning, uma análise

do cenário do mercado de marketplaces como recorte da indústria de varejo e por fim, aborda

dois estudos de caso de aplicações de machine learning na companhia identificada como

MarketplaceCo.

14

1.2 Motivações e Premissas

A revolução digital é caracterizada por uma internet móvel, por sensores menores e mais

eficientes, pela Inteligência Artificial (IA) e pelo Machine Learning (ML), podendo ser

traduzido como aprendizagem de máquina.

Na última década, o machine learning fez progressos significativos, impulsionado pelo

aumento exponencial da capacidade de processamento e pela disponibilidade de grandes

quantidades de dados. Os algoritmos aprendem a partir do histórico de dados com um processo

de aprendizagem e detecção automatizada de padrões que permite um aprimoramento contínuo

com o objetivo de encontrar melhores soluções a partir dos princípios iniciais.

Pereira, Castro et. al (2016) ressalta que escolher e implementar de forma a conciliar as

melhores tecnologias dentro do contexto organizacional consiste em uma atividade desafiadora

que demanda um conhecimento prévio das possíveis mudanças e impactos organizacionais.

De acordo com a pesquisa realizada pela MIT Sloan Review, Well e Woener (2017), na

indústria de varejo, foram entrevistados 653 executivos norte-americanos sobre o papel do

machine learning em suas atividades. Desses executivos da indústria varejo, 72% acreditam

que seus KPIs funcionais poderiam ser mais bem alcançados com maior investimento em

automação e tecnologias de ML. Nessa pesquisa, 62% dos executivos de varejo disseram que

sua organização possui incentivos internos para usar a automação e as tecnologias de ML para

impulsionar as atividades. Na amostra geral, esse número foi menor: apenas 49% dos

entrevistados relataram ter esses incentivos.

Na abordagem dos estudos de caso, um importante driver estratégico da empresa

escolhida, é fazer uso da tecnologia para melhorar os processos internos utilizando o machine

learning, em específico, em diversas áreas.

Neste contexto, o projeto tem como premissas a serem validadas ao seu decorrer:

I. Há cada vez mais demanda por aplicações de Inteligência Artificial;

II. A indústria de varejo busca inovações tecnológicas para ganhar vantagem competitiva;

III. O machine learning pode ser utilizado para melhorar os processos internos;

IV. O machine learning gera ganhos quantitativos efetivos na indústria do varejo.

15

1.3 Objetivos

Nesta seção é realizado o desdobramento dos objetivos do trabalho em uma visão geral

e seus objetivos específicos.

1.3.1 Objetivo geral

Os objetivos da pesquisa indicam a pretensão com o seu desenvolvimento e quais os

resultados esperados.

Este trabalho tem como objetivo geral identificar as categorias de tecnologias existentes,

com foco no machine learning e suas aplicações de forma a compreender de que forma o uso

de algoritmos pode agregar valor e otimizar os processos em uma empresa da indústria de varejo

no ramo de marketplace.

1.3.2 Objetivos específicos

Para que o objetivo geral fosse alcançado, os seguintes objetivos específicos foram

definidos:

I. Contextualizar brevemente a transformação digital e as categorias de tecnologias

cognitivas existentes;

II. Aprofundar no estudo do Machine Learning, o conceito, as técnicas, os passos para a

construção de um modelo e a operacionalização nas organizações;

III. Compreender o cenário do segmento de Marketplace, como um recorte da indústria de

varejo, além das principais aplicações de machine learning neste setor;

IV. Realizar estudos de caso com o objetivo de tangibilizar aplicações do machine learning

para melhoria de processos internos na área Comercial e na área de Trust&Safety da

MarketplaceCo;

V. Identificar o contexto e a construção dos modelos dos estudos de caso para propor uma

análise crítica acerca dos temas.

16

1.4 Estrutura do trabalho

Nesta seção é desdobrada a estrutura do trabalho em capítulos, suas delimitações e

limitações.

1.4.1 Descrição dos capítulos

No primeiro capítulo deste estudo, são apresentadas as motivações que levaram as

autoras a escolherem o tema estudado como objeto de pesquisa, bem como seus objetivos,

limitações e delimitações, evidenciando o recorte de aplicações do Machine Learning na

indústria de varejo.

No segundo capítulo, é apresentada a metodologia de pesquisa que suporta o trabalho

desenvolvido.

O terceiro, quarto e quinto capítulo compreendem a revisão bibliográfica. No terceiro

capítulo, é realizada uma breve conceituação de transformação digital, estratégia de

transformação digital e as categorias de tecnologias.

O capítulo quatro aprofunda no estudo de machine learning, bem como em suas

técnicas, algoritmos, quais são os passos necessários na construção de um modelo e a aborda

de forma geral os principais tópicos na operacionalização dos modelos em uma organização.

O capítulo cinco explora o contexto dos estudos de caso, a partir da caracterização do

setor de varejo, além das aplicações de machine learning na indústria de varejo.

O sexto capítulo aprofunda nos estudos de caso, caracterizando a empresa estudada,

descrevendo os algoritmos de machine learning que foram implementados na empresa, assim

como as motivações e os resultados alcançados. Neste capítulo também é feita uma análise

crítica dos estudos de caso do ponto de vista das autoras, com base na revisão bibliográfica da

literatura.

Por fim, o último capítulo apresenta as conclusões do trabalho com relação à aplicação

do machine learning na indústria de varejo, assim como apresenta recomendações para

pesquisas futuras.

17

1.4.2 Delimitações

O presente trabalho delimitou-se a apresentar uma visão descritiva da modelagem de

machine learning, sem aprofundar no estado da técnica em termos da codificação

computacional dos algoritmos. Apesar do machine learning pertencer ao conjunto de

Inteligência Artificial, esta será tratada apenas em linhas gerais para contextualização. Além

disso, limitou-se a categorizar as demais tecnologias de forma generalista.

Devido a abrangência de subsetores dentro da indústria de varejo, optou-se por realizar

os estudos de caso em uma empresa pertencente a subcategoria de marketplace, durante o

período de estágio de uma das autoras deste projeto. Sendo assim, o escopo destes estudos de

caso limitou-se às atividades desenvolvidas e ao acesso à informação durante o período de

realização do estágio.

1.4.3 Limitações

O tema estudado apresenta vasta quantidade de conteúdo nas bases acadêmicas,

entretanto, não foi realizada uma busca sistemática exaustiva na literatura, por este não ser o

objetivo principal do trabalho. Pelo fato de machine learning ser um tema atual e em evolução

contínua, se fez necessário o uso de relatórios de consultoria focados em tecnologia, assim como

artigos recentes sobre o assunto.

Outra limitação ocorreu em um dos dois estudos de caso trabalhados. Diferentemente

do segundo, sobre o modelo de identificação de fraudes no chat, que pode contar com acesso à

documentação e os dados do projeto, viabilizando uma análise mais aprofundada, no primeiro

estudo, sobre o modelo de cancelamento de planos, não foi possível realizar um maior

detalhamento, pela escassez de acesso à informações, tendo sido este todo desenvolvido com

base em entrevistas.

18

2. METODOLOGIA DA PESQUISA

A elaboração deste trabalho tem suas bases metodológicas pautadas em uma pesquisa

exploratório-descritiva, apoiada em métodos de estudo de caso e revisão da literatura. A

efetividade de aplicação do Machine Learning foi verificada qualitativamente através dos

estudos de caso, com caráter exploratório. Essa abordagem permite que os pesquisadores se

aproximem dos membros da organização a ponto de entender o que eles pensam, aumentando

o grau de investigação relacionado ao objeto de pesquisa (MAYKUT e MOREHOUSE, 1994).

Quanto ao caráter exploratório, Gil (2007) afirma que pesquisas exploratórias têm como

objetivo proporcionar maior familiaridade com um determinado problema, a fim de torná-lo

mais explícito ou a construir hipóteses. As pesquisas exploratórias envolvem: (i) levantamento

bibliográfico; (ii) entrevistas semiestruturadas com pessoas que tiveram experiências práticas

com o problema pesquisado; e (iii) análise de exemplos que estimulem a compreensão.

Para os capítulos de referencial teórico, utilizou-se principalmente fontes secundárias,

por meio de livros teóricos sobre Machine Learning recomendados. O primeiro, Artificial

Intelligence and Machine Learning for Business (FINLAY, 2017) foi escolhido por ter uma

abordagem sistêmica e processual da construção de um modelo de machine learning. O

segundo, Inteligência artificial: uma abordagem de aprendizado de máquina” (FACELI,

LORENA, et al., 2011), apresenta uma visão mais técnica e é recomendado pelo mestrado de

Ciência de dados do Instituto Militar de Engenharia. Além disso, foram utilizadas pesquisas

diretas no portal de periódicos da CAPES e SCIELO, assim como relatórios de consultorias

pela abordagem voltada ao ambiente corporativo.

A busca na base de periódicos CAPES e SCIELO utilizaram as seguintes palavras-

chave: machine learning; machine learning* + model*; machine learning* + applic*; machine

learning* + case study; industry 4.0; industry 4.0 + tech*; digital transf* + tech*; digital

transf* + applic*. Em todos os casos foram utilizados termos de busca em inglês para que um

universo maior de estudos acadêmicos fosse contemplado.

Para compreender a aplicação do objeto de estudo na prática, optou-se por aplicar

métodos de estudo de caso. Segundo Yin (2006), o estudo de caso é caracterizado pelo estudo

profundo e exaustivo dos fatos objetos de investigação, permitindo um amplo conhecimento

da realidade e dos fenômenos pesquisados.

No modelo de Cancelamento de Planos, foram realizadas entrevistas semiestruturadas

com o Cientista de dados responsável pela construção do algoritmo e com um Analista da área

Comercial, para compreender melhor a utilização prática do modelo pela Área de Retenção que

19

serão mais detalhadas no tópico 6.1.3. Para o modelo de Detecção de Fraude, foi utilizado

prioritariamente fontes primárias de informação, visto que uma das autoras participou

ativamente do desenvolvimento do projeto.

Com base no que foi levantado pela revisão bibliográfica da literatura, foi elaborado um

protocolo de estudos de caso divididos em duas partes. Primeiro, caracterizando os modelos de

machine learning em três categorias: (i) contexto; (ii) processo de construção e (iii) análise

crítica. Segundo, buscando compreender o problema de negócio, os processos envolvidos na

implementação, análise dos métodos e algoritmos utilizados, retorno da utilização dos modelos

e impacto organizacional.

20

3. TRANSFORMAÇÃO DIGITAL E INDÚSTRIA 4.0

A revisão da literatura se inicia neste capítulo, com o contexto de transformação digital

e indústria 4.0, categorias de tecnologias cognitivas e se estende pelos capítulos 4 e 5, com o

aprofundamento no machine learning e nas aplicações deste na indústria do varejo.

3.1 Conceito e panorama histórico

O conceito de transformação digital abordado no presente trabalho está relacionado a

mudança no perfil das indústrias por meio de tecnologias da informação e da comunicação. A

Indústria 4.0, também conhecida como quarta revolução industrial, é caracterizada pela

automação inteligente e integração de novas tecnologias na cadeia de valor dos negócios. Trata-

se de uma transformação digital que está impactando os negócios, não apenas nos sistemas e

processos, mas também os modelos de negócios e força de trabalho (SCHWAB, 2016).

Também chamada de digitalização ou negócios digitais, é definida como "a aceleração das

atividades, processos, competências e modelos empresariais para alavancar plenamente as

mudanças e oportunidades das tecnologias digitais e seu impacto de forma estratégica e

priorizada" (EDMEAD, 2016).

Em um breve histórico, a primeira revolução industrial iniciou-se ao final do século 18

com a invenção da máquina a vapor. A energia do vapor e o seu uso para fins industriais foi o

maior avanço para o aumento da produtividade humana. A Segunda Revolução Industrial

começou no século 19 através da descoberta de eletricidade e produção de linha de montagem,

na qual Henry Ford introduziu os princípios da produção em massa. Nos anos 1970, o início da

chamada era da informação caracterizou a terceira revolução industrial, com a introdução da

automação e da robótica. O uso dessas tecnologias desencadeia uma mudança significativa no

processo produtivo, como por exemplo, passa a existir a programação de robôs que executam

sequências programadas sem intervenção humana.

A quarta revolução industrial, que está em curso atualmente, iniciou-se com o

desenvolvimento das chamadas “fábricas inteligentes”, nas quais sistemas de produção,

componentes e pessoas se comunicam através de uma rede e a produção começa a apresentar

autonomia. Na Figura 1, pode-se visualizar, em uma linha do tempo, as revoluções e suas

principais mudanças (BARROS, 2018).

21

Figura 1: Contexto histórico das revoluções industriais

Fonte: Disponível em <https://alcerconsultoria.com.br/sem-categoria/industria-4-0-como-o-brasil-reagira/>.

Acesso em: 10 Dez 2019, às 12:57.

O estudo Customer Experience Index (CEI), realizado pela IBM, Glass e Haller (2017)

indicou que a digitalização é uma prioridade (87% dos líderes seniores empresariais), e

descobriu que as empresas estão fazendo investimentos em negócios digitais, porém a maioria

ainda está nos estágios iniciais de investigação e experimentação.

Com base no relatório publicado pelo Fórum Econômico Mundial (2018), a Quarta

Revolução Industrial não se trata de um prolongamento da Terceira Revolução Industrial devido

três características: velocidade, escopo e impacto nos sistemas. A velocidade das descobertas

atuais, quando comparada às revoluções anteriores, evoluiu exponencialmente. No mais, essa

mudança de estrutura tem repercussão em quase todos os setores da indústria e economia, o que

caracteriza um escopo amplo. Por fim, o impacto dessa transformação nos sistemas de

produção, gestão e governança, é o maior comparado ao histórico de revoluções.

Não há uma definição única do termo “transformação digital”, tampouco a determinação

de quais são suas interfaces nos negócios. Cada autor explica o fenômeno de maneira particular

e não é o objetivo do presente estudo ser extensivo nas definições do termo.

3.2 Estratégia de transformação digital

A transformação digital tem o potencial de gerar benefícios significativos para as

empresas, ligados essencialmente ao aumento de produtividade, aumento de segurança nas

22

operações e aumento do valor para o cliente. No entanto, a transição de um modelo tradicional

para um modelo digital requer adaptações. A complexidade envolve mudanças nas operações,

produtos, processos e nas estruturas organizacionais, de modo que as empresas precisam

estabelecer novas práticas de gestão para conduzi-la.

Em pesquisa com os representantes empresariais realizada pela consultoria Deloitte,

Xavier, Cotteleer et. al (2018) constatam que somente 14% consideraram suas empresas

preparadas para as mudanças da transformação digital. Esse resultado demonstra que, apesar de

entenderem conceitualmente as mudanças necessárias para adequação, não há clareza sobre

como deve ser a implantação e continuam a se concentrar em suas operações tradicionais.

O framework da Pirâmide da Transformação Digital, desenvolvido por Turchi (2018),

exposto na Figura 2, tem o objetivo de facilitar a definição de iniciativas de transformação

digital, ajudando a entender o impacto desta transformação nos modelos de negócio. Para isso,

o autor divide a abordagem da transformação digital em três níveis: estratégia, execução e

tecnologia.

Figura 2: A pirâmide da transformação digital

Fonte: Disponível em https://www.thedigitaltransformationpeople.com/channels/the-case-for-digital-

transformation/digital-transformation-pyramid-business-driven-approach-corporate-initiatives/. Acesso em: 11

Jan 2020, às 09:22.

A disposição da pirâmide materializa as abordagens da transformação digital nas

organizações seguindo uma ordem que representa a interface entre os níveis, bem como seus

graus de importância. Na base, as tecnologias habilitadoras salientam a necessidade de recursos

23

tecnológicos para possibilitar a condução da operação. No topo, a transformação do modelo de

negócios só é possível quando as outras categorias estão alinhadas e, dessa forma, dão suporte

às transformações do ponto de vista estratégico da organização.

Em termos de estratégia, classificado no modelo anterior como topo da pirâmide, é

preciso delimitar quais são os direcionadores (drivers) que a organização deve seguir para

garantir o cumprimento dos seus objetivos estratégicos. De acordo com o relatório sobre

transformação digital e a maximização do retorno sobre investimentos produzido pelo Fórum

Econômico Mundial (2018) a experiência do cliente se caracteriza como um driver estratégico

de investimentos digitais, por permitir a criação de ofertas personalizadas, apoiar jornadas de

decisão, aumentar a velocidade da transação e garantir a privacidade e confiança. Tal

categorização de direcionadores e habilitadores pode ser observado na Figura 3.

Direcionadores de

investimento

Habilitadores de

eficiência Habilitadores de crescimento

Ganho em eficiência Experiência do cliente e

receitas

Novos modelos de

negócio

Principais áreas

de investimento

− Automação de toda

a cadeia de valor, da

tomada de decisão

às operações.

− Uso eficiente de

recursos, tais como

tempo, energia,

matérias-primas e

ativos.

− Objetivos iniciais de

eficiência específica

com potencial para

expandir para novos

modelos de

negócios e

experiências do

cliente.

− Ofertas personalizadas

para criar "momentos

de verdade" e apoiar

jornadas de decisão.

− Integração das

informações do cliente

entre plataformas para

aumentar a velocidade

da transação.

− Novas experiências

com base na

privacidade e

confiança, gestão de

relacionamento com o

cliente, uso do

marketing digital.

− Atender às

necessidades do

mercado com a

combinação de dados

e tecnologias.

− Construir um

entendimento

profundo da cadeia de

valor e aumentar o

potencial de

escalabilidade de

oportunidades.

− Abordar os negócios

existentes

concentrando-se na

demanda do

consumidor e o custo

de oportunidade.

Figura 3: Quadro de direcionadores de investimento de acordo com habilitadores de eficiência e de crescimento

Fonte: Adaptado do Fórum Econômico Mundial (2018, p.9)

Em um artigo publicado no MIT Sloan Review, Weill e Woerner (2017) identificaram

2 dimensões de negócios para avaliar a prontidão digital das corporações: experiência do cliente

24

e eficiência operacional. No geral, é perceptível que a transformação digital não é somente sobre

tecnologia, mas também sobre transformações nos modelos de negócio (CHINEN, 2019).

De acordo com a plataforma de conteúdo que fomenta inovação e tecnologia AAA

inovação, Amaral (2019) cita que o primeiro domínio da Transformação Digital deve ser o foco

no cliente. No passado, as empresas tratavam os clientes como receptores. Entretanto, hoje as

marcas devem entender a sua comunicação como uma via de mão dupla, no qual o cliente tem

papel fundamental.

Dessa forma, surge o modelo Customer-Centric, representado na Figura 4, no qual o

foco central das empresas são os clientes. Segundo uma pesquisa da Deloitte (2018), empresas

centradas nos clientes lucram até 60% mais do que aquelas que não são.

Figura 4: Modelo de Customer-centric

Fonte: Adaptado, disponível em: <http://blog.aaainovacao.com.br/entenda-o-que-e-e-como-aplicar-a-

transformacao-digital/>. Acesso em 16 Dez. 2019, às 10:54

O foco nas necessidades tem relação com o fato de criar algo que realmente traga valor

para o cliente, validando continuamente as hipóteses com o consumidor final. A construção do

relacionamento tem relação com a experiência do cliente, tanto no processo de recomendação

de produtos e serviços como na finalização de compras, proporcionando uma comunicação

personalizada em que ocorre a percepção de exclusividade por parte do cliente.

A visão holística se conecta ao pensamento sistêmico dentro da organização, em que a

experiência do cliente não está vinculada somente aos departamentos com relação direta com o

consumidor, de forma que as equipes de suporte também devem ter esse driver para que ocorra

um acompanhamento de toda a jornada do consumidor. Por fim, a liderança se apresenta como

25

pilar para sustentar o funcionamento das demais esferas de maneira coesa. De acordo com

Ribeiro, Rocha e Branco (2012), os líderes tornam-se cada vez mais uma importante fonte de

vantagem competitiva para as empresas na economia mundial interconectada.

Dessa forma, a indústria deve estar hábil a compreender as mudanças no comportamento

dos clientes e seus hábitos. De acordo com a pesquisa Customer Experience Index (CEI)

realizada pelo IBM (2017), a experiência do cliente superará o preço e o produto como

diferenciador-chave de uma marca. Quantitativamente, 86% dos compradores pagarão mais

para terem uma melhor experiência.

3.3 Categorias de tecnologias

A transformação digital, tanto citada até aqui, foi e vem sendo viabilizada e

operacionalizada a partir de tecnologias e suas evoluções. Logo, a compreensão do impacto que

elas vêm criando no mercado e suas funcionalidades é fundamental.

O objetivo deste tópico será abordar as tendências de uso, resultados gerados nos

últimos anos e descrever as principais tecnologias da indústria 4.0. Vale ressaltar que se trata

de uma breve abordagem, pois a exploração exaustiva de todas as tecnologias digitais está fora

do escopo deste projeto.

3.3.1 Resultados financeiros e tendências de crescimento

O estudo realizado pelo Fórum Econômico Mundial (2018) realiza análises qualitativas

e quantitativas com dados de mais de 16.000 empresas públicas de 14 setores foram analisadas

para estimar o impacto na produtividade dos investimentos em novas tecnologias digitais. Em

2016, os investimentos chegaram a 1,5 trilhões de dólares, com maior representatividade de

Internet of Things (IoT) (41%) e Mobile/Mídia Social (35%).

Em relação às tendências esperadas, a International Data Corporation (IDC) estimou

que, entre 2016 e 2020, os investimentos em tecnologias iriam crescer em Compound Annual

Growth Rate (CAGR) de 13% ao ano. Foi estimado que o crescimento seria liderado por

investimentos em IoT, aproximadamente US$1,0 trilhão, e Mobile/Mídia Social

permaneceriam estáveis, levando sua participação no total de investimentos de 35% para 25%.

Quanto ao retorno aos investimentos, como ilustrado na Figura 5, quando analisados

sozinhas, as Tecnologias Cognitivas – incluem Inteligência Artificial (IA) e Big Data Analytics

(BDA) – realmente são o maior potencializador de crescimento (Receita por funcionário),

enquanto a Robótica é a que traz maior produtividade – Earnings before Interest, Taxes,

26

Depreciation and Amortization (EBITDA) por funcionário. Enquanto isso, a IoT, tecnologia de

maior volume de investimento, obteve menor resultado em crescimento e produtividade. Por

outro lado, se as tecnologias são desenvolvidas em conjunto, estimativas mostram que a

produtividade poderia ser três vezes maior que quando desenvolvidas sozinhas.

Figura 5: Produtividade e crescimento por tipo de tecnologia

Fonte: Fórum Econômico Mundial (2018, p.10)

As métricas de crescimento e produtividades são normalizadas pela quantidade de

funcionários e podem ter comportamento diferente por tipo de setor industrial, visto que em

setores de Serviços em que o diferencial é o atendimento humanizado e, com isso, têm menos

elasticidade na redução do corpo de trabalho.

Na média, uma companhia de capital pesado ou de serviços obtém similares ganhos em

produtividade, apesar de com diferentes tipos de tecnologia (pode ser observado pela Figura 6).

Figura 6: Produtividade por classe industrial

Fonte: Fórum Econômico Mundial (2018, p.10)

27

Quanto à posição das empresas, é observável uma dualidade entre os retornos trazidos

pelas diferentes tecnologias de acordo com as características de funcionamento. Em

companhias líderes, maiores e com sistemas mais maduros, obtêm maior produtividade de

Robótica e Mobile/Mídias sociais (infraestrutura de rede) visto que a integração de automação

se torna mais simples em sistemas mais maduros, com arquitetura e regras definidas. Contudo,

as demais companhias, menores e mais novas, obtêm maior produtividade de IoT e Tecnologias

Cognitivas – estas companhias têm sistemas e modelos novos que podem ser configurados com

preparação a novas tecnologias, enquanto em grandes companhias repletas de sistemas legados,

há maior rigidez de modificações e experimentação. Os números de produtividade empresas

líderes e “seguidoras” estão ilustrado na Figura 7.

Figura 7: Produtividade (EBITDA por funcionários) companhias líderes vs. seguidoras

Fonte: Fórum Econômico Mundial (2018, p.12)

No artigo divulgado pela consultoria McKinsey (2019), é possível perceber o perfil de

investimento de empresas de alta performance em transformação digital. As companhias líderes

equilibram suas prioridades estratégicas entre a digitalização de seus principais negócios e a

criação de modelos de negócios digitais inovadores. De acordo com a Figura 8, pode-se notar

que as empresas com melhor desempenho comprometem tantos recursos no desenvolvimento

de novos negócios digitais quanto na digitalização de seu core business.

28

Figura 8: Alocação % de capital digital das organizações de 2017 a 2019 por objetivo

Fonte: McKinsey (2019, p.1)

3.3.2 Conceitos

Para compreender a difusão da transformação digital em todos os setores da indústria e

os resultados gerados, é necessário a identificação dos recursos que geram esse fenômeno – as

tecnologias.

Para cada categoria de tecnologias, de acordo com o objetivo do projeto, há diferentes

aplicações. Segundo o Fórum Econômico Mundial (2018) na linha de frente da maximização

da eficiência estão a Robótica e IoT, enquanto as Tecnologias Cognitivas e Mídia Social estão

para o objetivo de crescimento, conforme Figura 9.

29

Direcionadores de

investimento

Habilitadores de eficiência Habilitadores de crescimento

Ganho em eficiência Experiência do cliente e

receitas

Novos modelos de

negócio

Tecnologias

habilitadoras

− Internet das coisas e

robótica para

automatizar processos

e coleta dados.

− Combinação de Big

Data, Inteligência

Artificial, visão 3D e

plataformas digitais

para analisar dados

para identificar

eficiências

incrementais.

− Análise Big Data para

personalização de

clientes.

− Computação em nuvem

para reforçar a gestão

de dados.

− Mídias sociais e

tecnologias móveis para

melhorar o

engajamento.

− Análise Big

Data para

identificar novas

demandas do

cliente.

− Mídias sociais e

tecnologias

móveis para

melhorar o

engajamento.

Complexidade

− Normalmente baixa,

semelhante a

investimentos

tradicionais.

− Business case

relativamente fácil de

certo.

− Tipicamente média-alta.

− Impacto nas métricas de

experiência do cliente

com eventual

crescimento de receita.

− Normalmente

alta.

− Business case

relativamente

incerto.

Figura 9: Quadro de classificação de tecnologias por tipos de objetivos estratégicos

Fonte: Adaptado do Fórum Econômico Mundial (2018, p.9)

Relacionando aos dados mencionados anteriormente, notou-se que Robótica e Mobile

foram líderes em eficiência (EBITDA/funcionário – métrica aproximada pelo Fórum

Econômico Mundial) e as Tecnologias Cognitivas foram líderes em crescimento. Esse trabalho

não tem por objetivo realizar uma análise crítica de métricas de produtividade, apesar desta

referência não abranger os outros ativos possíveis de uma organização – como por exemplo,

uso de máquinas.

Foram analisadas as principais tecnologias que compõem a indústria 4.0 com o intuito

de ter uma visão geral do objetivo e aplicação destas na indústria. Para isso, foram utilizados

os conceitos de duas fontes principais: Schallmo, Williams e Luke (2017) e Fórum Econômico

Mundial (2018). Além disso, foram incluídas outras tecnologias que fazem parte dos processos

da indústria 4.0. O modelo da Figura 10 ilustra a Indústria 4.0 por suas etapas no ambiente

corporativo em relação ao fluxo de dados.

30

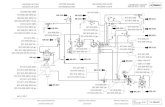

Figura 10: A indústria 4.0 nos processos corporativos

Fonte: Elaboração própria (2020)

O Ambiente de dados digitais é criado a partir da geração de dados pelo Sensoriamento,

capacidade de processamento rápido pela Infraestrutura de Rede, criação da capacidade

computacional para armazenamento destes dados pela Computação em Nuvem combinados à

Cibersegurança garantindo a confiança das transações de dados digitais. Neste ambiente são

criados e transferidos dados não estruturados – sem significado – para as demais etapas da

indústria 4.0. Na etapa Geração de Informação, as Tecnologias Cognitivas transformam os

dados não estruturados em informação para as áreas de negócio e para as áreas técnicas da

Operação, assim como os softwares de Simulação os utilizam para informação nos testes de

processo.

A Operação está cada vez mais automática, seja por hardwares (robôs), seja por

softwares – Robotic Process Automation (RPA) e aplicativos adicionais – utilizam os dados não

estruturados para funcionamento e informações para a tomada de decisão, enquanto a Internet

das Coisas conecta os equipamentos pelo fluxo de dados. Além disso, a Realidade Aumentada

complementa a Operação no treinamento de operadores e utilização por clientes, no caso de

Serviços. Na etapa final, de Acesso Digital ao Cliente, é criado um novo canal de frontend –

uso direto pelo cliente – para vendas ou suporte ao cliente por aplicativos e redes sociais. Os

31

dados utilizados podem retornar para o ambiente de dados digitais, o que acaba tornando um

ciclo de reforço.

Segundo o artigo Maximizing Return on Digital Investments do Fórum Econômico

Mundial (2018), as áreas de investimento tecnológico que compõem a transformação digital

são categorizadas em quatro áreas: Tecnologias Cognitivas, IoT, Robótica e Mobile/Mídia

Social. Estas são definidas como:

I. Tecnologias cognitivas: inclui Inteligência Artificial (IA) e Big Data Analytics (BDA).

A IA tem como principais métodos o Natural Language Processing (NLP) – para

responder a questões e para fornecer recomendações – e o Machine Learning para

reconhecimento de padrões. O BDA é composto por tecnologias com arquiteturas

projetadas para extrair valor e eficiência de grandes volumes de dados.

II. IoT: refere-se a uma rede que agrega e vincula parâmetros unicamente identificáveis

que se comunicam de forma autônoma usando a conectividade do protocolo da internet.

III. Robótica: abrange o projeto, construção, implementação e operação de robôs. A

automação robótica de processos (RPA), interfaces cognitivas e outros aplicativos de

software que não são capazes de movimento são excluídos.

IV. Mobile/mídia social: inclui soluções de mobilidade e tecnologias sociais. Soluções de

mobilidade incluem os dispositivos, software, infraestrutura e serviços relacionados que

habilitam serviços de dados móveis. Tecnologias Sociais facilitam a colaboração entre

stakeholders, parceiros, fornecedores e clientes, bem como a extração de dados dessas

comunicações.

No tocante à categorização, as Tecnologias Cognitivas, IoT, Robótica e Mídia Social

são primárias, pois podem exercer funções de digitalização de processos. Enquanto Mobile,

como relacionado à infraestrutura de rede que habilita a comunicação de dados, é uma

tecnologia de suporte – que viabiliza o ambiente de dados digitais.

De acordo com Schallmo, Williams e Luke (2017), há quatros categorias habilitadoras:

(i) dados digitais, (ii) acesso digital ao cliente, (iii) automação e (iv) redes. São definidos como:

I. Dados digitais: A coleção, processamento e análise de dados digitalizados.

II. Acesso digital ao cliente: A internet móvel permite acesso direto ao cliente com

alto nível de transparência e novos serviços.

III. Automação: A combinação de tecnologias de inteligência artificial clássica que

permita trabalho autônomo e sistemas auto-organizados.

32

IV. Redes: As redes móveis ou com fio em toda a cadeia de valor via banda larga de

alta velocidade permite a sincronização da cadeia de suprimentos.

Figura 11: Radar digital com habilitadores e aplicações

Fonte: Boueé e Schaible (2015, p.9)

Na Figura 11 é possível entender a abrangência do meio digital, com seus habilitadores

e aplicações (BOUEÉ e SCHAIBLE, 2015, p. 9). Além das tecnologias citadas, a Computação

em nuvem, Sensoriamento, Cibersegurança, Sistemas Ciberfísicos, Realidade aumentada e

Simulação são categorias fundamentais à transformação digital e, por esse motivo, também

foram categorizadas como habilitadoras. Como o projeto tem o foco em uma subcategoria de

IA - Machine Learning – esta subcategoria será melhor detalhada no decorrer da pesquisa.

Computação em nuvem

Segundo a definição apresentada por Correia (2011), como proposta pelo Instituto

Nacional Americano de Padrões e Tecnologia (NIST), que descreve a computação em nuvem

como “…um modelo para permitir acesso onipresente, conveniente e de rede sob demanda a

um conjunto compartilhado de recursos de computação (por exemplo, redes, servidores,

armazenamento, aplicativos e serviços) que podem ser rapidamente providos com o mínimo

esforço de gerenciamento ou interação com o provedor de serviços... ". Em detalhe, a

computação em nuvem pode ser dividida em duas camadas: o frontend e backend.

O frontend se refere à interface com o usuário que utiliza os serviços e aplicações online,

possivelmente de maneira compartilhada com outros em qualquer dispositivo com acesso à

33

rede. Enquanto isso, o backend é composto pelo hardware (necessário à comunicação com a

rede) e software de servidores, computadores, máquinas virtuais e sistemas de armazenamento.

Um servidor é usado para gerenciar toda a arquitetura do sistema em nuvem e é o responsável

por lidar com a suavidade do tráfego sem interrupções. Além disso, utiliza-se o middleware,

tipo específico de software, usado para executar processos e conectar computadores em rede.

A computação em nuvem revolucionou as informações e indústria de tecnologia,

desempenhando um papel importante no atendimento às crescentes demandas de

armazenamento e infraestrutura Rashid (2019). Com seu surgimento, foram introduzidas a

flexibilidade de acesso, uso sob demanda e rápida elasticidade, além da redução de custos com

a compra, manutenção provisão de energia aos hardwares.

Com o crescimento exponencial de dados, representa a tecnologia que realiza o

armazenamento seguro e eficiente acesso pelos usuários finais e, com isso, é considerada uma

tecnologia de suporte.

Sensoriamento

Os sensores habilitam a captura de dados digitais e realizam a comunicação entre estes.

Os sensores são instalados em sistemas que realizam a comunicação com as tecnologias que

utilizam os dados como insumo. Dessa forma, o sensoriamento é considerado um dos maiores

drivers da Industria 4.0. A Figura 12 ilustra as características dos sensores durantes as

revoluções industriais de Sensors 4.0 – sensores inteligentes e tecnologias de medição como

habilitadores da indústria 4.0 (SCHÜTZE, HELWIG e SCHNEIDER, 2018).

34

Figura 12: Evolução histórica dos sensores 1.0 aos sensores inteligentes

Fonte: Schütze, Helwig e Schneider (2018, p.3)

Os sensores inteligentes têm o diferencial de serem equipados com uma interface digital.

Estes dispositivos recebem os sinais de um ambiente físico e realizam a comunicação através

da interface com o usuário. Esses sensores podem transmitir um código binário usando, por

exemplo, um LED de diodo (ligar/desligar), indicador de mudança de cor ou um display de

cristal líquido (LCD). As telas de LCD podem exibir caracteres, símbolos ou gráficos e podem

ser maiores e mais complexas à medida que aumenta a complexidade dos dados a serem

transferidos (SCHÜTZE, 2018).

Cibersegurança

Com a digitalização dos dados e armazenamento em nuvem, a segurança de informações

também é realizada de forma digital, conhecida como cibersegurança. A cibersegurança é uma

prática de proteção de sistemas e redes contra-ataques cibernéticos composta principalmente

por software de criptografia que codificam os dados e apenas o usuário final tem acesso a chave

para descriptografar e protocolos eletrônicos que realizam análise heurística do comportamento

dos programas.

As formas de ataques cibernéticos são o acesso, mudança ou deleção de dados

sensíveis, extorsão de usuários ou interrupção de processos. Os métodos mais comuns usados

pelos invasores para controlar computadores ou redes são os vírus, worms, spyware e cavalos

de tróia. Os vírus e worms são capazes de se replicar e danificar arquivos ou sistemas, enquanto

35

o spyware e os cavalos de Tróia são usados para coletar dados clandestinamente. Normalmente,

o usuário comum tem contato com o código malicioso por meio de algum anexo de e-mail não

solicitado ou pelo download de programas que parecem legítimos, mas que carregam malware.

Sistemas Ciberfísicos

Cyber Physical Systems (CPS) são sistemas em rede de componentes cibernéticos

(computação e comunicação) e físicos (sensores e atuadores) que interagem em um ciclo de

feedback com a possível ajuda da intervenção, interação e utilização humana (YOUSEF,

ALMAJI, et al., 2017). Em geral, um CPS consiste em dois componentes funcionais principais:

(1) a conectividade avançada que garante aquisição de dados do mundo físico em tempo real e

feedbacks do espaço cibernético; e (2) gerenciamento inteligente de dados, análise e capacidade

computacional que constrói o espaço cibernético.

O sistema apresenta sensores para capturar informação sobre o que está acontecendo no

mundo físico, converte os dados para envio ao nível ciber que atua como hub central das

informações da rede de máquinas que irá realizar análises dos dados para fornecer às máquinas

a auto comparação com as demais. Com o status das máquinas, os dados serão enviados para

infográficos para transferir as informações aos usuários e, então, serão tomadas decisões pelas

regras embutidas ao software do sistema ou pelos usuários. Enfim, o feedback irá do sistema

ciber para o sistema físico – e assim é gerado um loop.

Realidade aumentada

A realidade aumentada refere-se a dispositivos que realizam a integração do mundo real

ao virtual em tempo real. Os dispositivos são o hardware e software de câmeras interligados a

algoritmos gráficos que constroem cenários digitais integrados ao ambiente físico. É utilizada,

geralmente, em serviços de testes, experimentação ou jogos.

Simulação

A simulação é uma composição de softwares que imitam a realidade dos processos

virtualmente sendo utilizada para entender melhor os processos ou obter previsões. Softwares

de simulação permitem que a operação seja testada e, consequentemente, otimizada, evitando

perdas de grande escala.

Na era digital, a demanda dos consumidores vem mudando radicalmente e a

necessidade de customização requer linhas de produção mais flexíveis e, com isso, a simulação

36

se integra ao gerenciamento do ciclo de vida do produto. Com a facilitação do sensoriamento

de dados e capacidade de armazenamento de dados, são criadas simulações que facilitam a

tomada de decisão em tempo real, além da criação de cronogramas otimizados.

Inteligência Artificial

Define-se Inteligência Artificial como a capacidade dos programas computacionais de

operar de forma em que se acredita imitar os processos de pensamento humano (COLLINS,

2018). Tais processos podem ser agrupados em seis tipos de IA: Aprendizado de máquina,

Processamento de linguagem natural, Reconhecimento de fala, Reconhecimento de imagens,

Robótica e Planejamento. Com foco no primeiro, o aprendizado de máquina compreende o

desenvolvimento de algoritmos que permitem o sistema aprender com experiências passadas

(dados históricos), identificar padrões através de métodos estatísticos, fazer uma determinação

ou predição e melhorar seu desempenho automaticamente (JAVAPOINT, 2019).

37

4. MACHINE LEARNING

O presente capítulo faz parte da revisão da literatura quanto ao estudo de machine

learning. Neste capítulo, são aprofundadas as técnicas de aprendizado de máquina, são citados

de maneira breve os principais algoritmos de ML, é detalhado o processo de construção de um

modelo, as diferenças de machine learning e ferramentas estatísticas básicas e por fim, como o

modelo é operacionalizado nas organizações.

4.1 Conceito

Este subcapítulo é baseado no livro “Inteligência artificial: uma abordagem de

aprendizado de máquina” de Faceli, Lorena et al. (2011). Em 1956, considera-se o marco zero

da Inteligência Artificial pela criação do campo de pesquisa na conferência de Dartmouth

College. Era vista como uma área teórica com aplicações em problemas desafiadores, mas com

pouco valor prático. A programação utilizada na época era resolvida pela codificação de regras

táticos para a solução do problema. Tal modelo de programação ainda é muito utilizado, no

entanto, de acordo com Facelli, Lorena et. al (2011):

A partir da década de 1970, houve uma maior disseminação do uso de técnicas de computação

baseadas em IA para a solução de problemas reais. Em grande parte das aplicações, a obtenção do

conhecimento se dava via especialistas de um dado domínio. Nas últimas décadas, com a evolução dos

problemas a serem tratados computacionalmente e o volume de dados gerados por diferentes setores,

surge a busca por técnicas computacionais mais sofisticadas e autônomas, que reduzissem a necessidade

da intervenção humana. E para isso, essa técnica deveria ser capaz de, por si próprias, criar hipóteses ou

funções a partir da experiência passada que resolva o problema proposto. A essa técnica dá-se o nome de

Aprendizado de Máquina ou Machine Learning (FACELLI, LORENA et. al, 2011, p.2).

O Machine Learning é um ramo da Inteligência Artificial, podendo dessa forma, ser

classificado como uma subcategoria das Tecnologias Cognitivas. Este emprega uma variedade

de técnicas estatísticas, probabilísticas e de otimização que permitem computadores a aprender

e detectar padrões difíceis de discernir a partir de dados passados dos parâmetros analisados.

No entanto, deve-se notar que, em contraste com a IA tradicional, o aprendizado de

máquina não tem por objetivo único automatizar uma tarefa que o ser humano faria de forma

repetitiva ou demorada, mas usar os pontos fortes e habilidades especiais dos computadores

para complementar a inteligência humana. Por exemplo, a capacidade de digitalizar e processar

enormes bancos de dados permite que programas de aprendizado de máquina detectem padrões

que estão fora do escopo da percepção humana (SHALEV-SCHWARTZ e BEN-DAVID,

2014).

38

Simon (2013) definiu o objetivo dos processamentos de aprendizado de máquina como

a derivação de modelos preditivos a partir de dados atuais e históricos. Dessa forma, a tendência

é que o algoritmo aumente a precisão e acurácia à medida que ocorram mais iterações. Os

algoritmos de aprendizagem de máquina podem alcançar resultados extremamente eficientes

para domínios muito restritos usando modelos treinados a partir de grandes conjuntos de dados.

Alpaydin (2014), afirma que com o uso de ferramentas de machine learning podem ser

detectados certos padrões. Tais padrões permitem mapear o processo e realizar predições de

forma que se assume que o futuro não será muito diferente do passado onde o dado dessa

amostra foi coletado, e assim é possível esperar que as predições futuras estejam corretas.

4.2 Técnicas

De forma geral, há quatro principais técnicas de modelagem de machine learning:

Aprendizado supervisionado, Aprendizado não supervisionado, Aprendizado semi-

supervisionado e Aprendizado por reforço. A Figura 13 apresenta as categorias de machine

learning.

Figura 13: Técnicas de Machine learning por categorias.

Fonte: Adaptado de Mohammed, Khan e Bashier (2017, p.7)

Segundo Castle (2018), a maior diferença entre o aprendizado de máquina

supervisionado e não supervisionado é o fato dos algoritmos de aprendizado de máquina

supervisionados serem treinados em conjuntos de dados rotulados que orientam o algoritmo a

entender quais recursos são importantes para o problema em questão. Por outro lado, os não

supervisionados, são treinados em dados não rotulados e devem determinar a importância do

recurso por conta própria, com base nos padrões inerentes à amostra.

39

O Aprendizado supervisionado é utilizado, normalmente, para a predição de eventos.

Na aprendizagem supervisionada, o objetivo é inferir uma função ou mapeamento a partir de

dados de treinamento. Mohammed, Khan e Bashier (2017) definem que os dados de

treinamento consistem no vetor de entrada X e no vetor de saída Y de rótulos. Um rótulo do

vetor Y é a explicação de seus respectivos dados de entrada. Em outras palavras, ao utilizar o

aprendizado supervisionado, obtém-se conhecimento prévio de quais devem ser os valores de

saída para nossas amostras, podendo dados incorretos interferirem na eficácia do modelo.

O aprendizado supervisionado geralmente é realizado no contexto de classificação,

quando se quer mapear a entrada para os rótulos de saída. Tanto na regressão quanto na

classificação, o objetivo é encontrar relacionamentos ou estruturas específicas nos dados de

entrada que nos permitam produzir efetivamente dados de saída corretos. De acordo com Soni

(2018), o objetivo do aprendizado supervisionado é aprender uma função que, dada uma

amostra de dados e resultados desejados, se aproxima melhor da relação entre entrada e saída

observável nos dados. Ainda segundo Soni (2018), ao conduzir o aprendizado supervisionado,

as principais considerações a serem feitas são em relação a complexidade do modelo e o trade-

off de viés e variância.

O Aprendizado não supervisionado é utilizado para a descrição de eventos ainda não

conhecidos. As tarefas mais comuns no aprendizado não supervisionado são agrupamentos,

aprendizado de representação e estimativa de densidade. Em todos esses casos, deseja-se

aprender a estrutura inerente dos dados sem usar rótulos fornecidos explicitamente.

Dois casos de uso comuns para aprendizado não supervisionado são análise exploratória

e redução de dimensionalidade. O aprendizado não supervisionado, por não possuir saídas

rotuladas, é útil na análise exploratória porque pode identificar automaticamente a estrutura nos

dados. Por exemplo, ao tentar segmentar consumidores, métodos de cluster não supervisionados

seriam uma possibilidade ponto de partida para análise.

Os algoritmos de aprendizado não supervisionado aprendem a partir dos dados. Quando

novos dados são introduzidos, o modelo usa os recursos aprendidos anteriormente para

reconhecer a classe de dados que está sendo tratada. De acordo com Soni (2018), em situações

em que é impossível ou impraticável para um ser humano propor tendências nos dados, o

aprendizado não supervisionado pode fornecer informações iniciais que podem ser usadas para

testar hipóteses individuais.

No Aprendizado semi-supervisionado, os dados fornecidos são uma mistura de dados

rotulados e não rotulados. Essa combinação de dados rotulados e não rotulados são usados para

40

gerar um modelo apropriado para a classificação dos dados. Segundo Mohammed, Khan e

Bashier (2017), na maioria das situações, os dados rotulados são escassos e os não rotulados

estão em abundância.

De acordo com Castle (2018), o processo de rotular grandes quantidades de dados para

aprendizado supervisionado geralmente leva muito tempo e tem custo elevado. Além disso,

rótulos excessivos podem impor vieses humanos ao modelo. Isso significa que incluir muitos

dados não rotulados durante o processo de treinamento tende a melhorar a precisão do modelo

final enquanto reduz o tempo e o custo gastos na construção.

O método de aprendizado por reforço visa usar observações reunidas a partir da

interação com o meio ambiente para tirar ações que maximizam o ganho ou minimizam o risco.

Dessa forma, com o uso deste método, é possível determinar o comportamento ideal que um

algoritmo deve apresentar dentro de um contexto específico.

O aprendizado por reforço procura resolver o problema de correlacionar ações imediatas

com os retornos atrasados que elas produzem. Eles operam em um ambiente de retorno atrasado,

onde pode ser difícil entender qual ação leva à qual resultado ao longo de várias etapas.

O aprendizado por reforço difere do aprendizado supervisionado de maneira que, no

aprendizado supervisionado, os dados de treinamento possuem a chave de resposta, de modo

que o modelo é treinado com a resposta correta, enquanto no aprendizado por reforço, não há

resposta, mas o algoritmo de reforço decide o que fazer para executar a tarefa especificada.

Na ausência de um conjunto de dados de treinamento, o modelo aprende por meio da

experiência e age sequencialmente. Segundo Menon (2018), o processo em que o algoritmo

executa uma ação para obter uma recompensa e passa para a próxima etapa é chamado de

Processo de Decisão de Markov. Em um Processo de Decisão de Markov, o estado futuro é

decidido com base em onde se está atualmente. Uma aplicação do aprendizado por reforço se

dá nos jogos de computador em que a máquina muda seu movimento de acordo com o

movimento dado pelo humano que se caracteriza como adversário.

4.3 Algoritmos

Há diversos tipos de algoritmos de machine learning que são classificados com base nas

técnicas descritas no item 4.2, a citar: Aprendizado supervisionado, Aprendizado não

supervisionado, Aprendizado semi-supervisionado e Aprendizado por reforço.

A seleção do algoritmo de machine learning que melhor se adequa a aplicação

pretendida de aprendizado de máquina para alcançar melhores resultados, às vezes, pode ser a

41

parte mais difícil. Wujek, Hall e Gunes (2016), em seu estudo, revelam que a decisão de qual

algoritmo usar pode ser orientada respondendo a perguntas importantes, como exposto na

Figura 14.

Perguntas Fatores de análise

1. Qual é o tamanho

e a natureza dos

dados?

Modelos lineares costumam ser uma boa escolha para grandes

conjuntos de dados devido à eficiência do treinamento.

Relacionamentos mais complexos podem ser modelados através de

algoritmos mais sofisticados como, como árvores de decisão, florestas

aleatórias, redes neurais e sistemas não-lineares. Algoritmos mais

sofisticados costumam exigir mais tempo de treinamento e podem ser

inadequados para conjuntos de dados muito grandes.

2. O que você deseja

atingir com o

modelo?

O propósito do modelo é classificar dados, prever um valor para uma

meta de intervalo, detectar padrões ou anomalias, ou fornecer

recomendações? Responder o resultado esperado auxilia no

direcionamento para um subconjunto de algoritmos de aprendizado de

máquina especializados no tipo específico de problema.

3. Quão preciso o

modelo precisa ser?

Modelos mais simples treinam mais rápido, são mais fáceis de

implantar e de entender, facilitando a explicação de como e por que os

resultados foram alcançados. Um benefício adicional de um modelo

mais simples é que ele será menos propenso a overfitting dos dados de

treinamento.

4. Quanto tempo há

disponível para

treinar o modelo?

O tempo de treinamento está diretamente relacionado a precisão

desejada pelo modelo. Para treinar um modelo em um curto espaço de

tempo, árvores de regressão e regressão linear ou logística,

provavelmente são boas opções. Se o tempo de treinamento não for um

problema, podem ser utilizados algoritmos mais robustos (redes

neurais, máquinas de vetores de suporte, aumento de gradiente etc.)

que refinam iterativamente o modelo.

5. Quão interpretável

e compreensível o

modelo precisa ser?

Se a capacidade de interpretação ou a documentação explicável forem

importantes, é aconselhado o uso de árvores de decisão ou alguma

técnica de regressão, levando em consideração a possibilidade do uso

de técnicas de regressão penalizada, modelos aditivos generalizados,

ou média do modelo para refinar seu modelo. Se for necessário garantir

alta precisão, mas ainda precisar explicar os resultados do modelo, uma

abordagem comum é treinar um modelo complexo, usar esse modelo

para gerar valores-alvo previstos, e em seguida, usar esses valores

previstos para treinar uma árvore de decisão.

Figura 14: Quadro Perguntas e fatores de análise para escolha de um algoritmo.

Fonte: Adaptado de Wujek, Hall e Gunes (2016, p.13)

42

Tendo em vista que o objetivo da presente pesquisa não consiste em realizar uma busca

exaustiva de algoritmos de machine learning na literatura, este subcapítulo, com base no estudo

realizado por Wujek, Hall e Gunes (2016), se restringe a citar os principais algoritmos, quais

são as aplicações mais comuns, qual é o tamanho/escala dos dados ideal para a utilização e a

facilidade de interpretação dos fatores que levam ao resultado do modelo, conforme exposto no

Apêndice – Características dos principais algoritmos de machine learning (p. 102 a 105).

4.4 Processo de construção de um modelo de machine learning

Nos tópicos anteriores foi realizada uma revisão teórica das principais técnicas

disponíveis para o desenvolvimento de um modelo de aprendizado de máquina, conhecimento

necessário para a prática em que serão escolhidas as melhores técnicas e algoritmos para o caso

desejado.

Neste tópico será abordada a prática de desenvolvimento de um modelo genérico de

machine learning, baseando-se nos conceitos de construção de modelos do livro Artificial

Intelligence and Machine Learning for Business de Steven Finlay (2017). O desenvolvimento

do modelo é realizado por nove macroetapas, identificadas na Figura 15.

Figura 15: Etapas do desenvolvimento de um modelo genérico de machine learning

Fonte: Adaptado de Finlay (2017, p.80)

43

4.4.1 Definição do problema de negócio

Identifica-se uma necessidade no negócio: identificar os melhores consumidores. Os

melhores consumidores são aqueles que geram maior retorno financeiro. Porém, são eles

clientes individuais ou uma família? São os que geram maior retorno por visita ao site? Por

produto comprado? Por um período (mês, trimestre ou ano)? Logo, é necessário estressar o

objetivo macro até que se chegue a um entregável concreto esperado do modelo.