Combinação de Preditores utilizando o Coeficiente de Correlação aplicado aos Problemas de...

-

Upload

brian-morgado -

Category

Documents

-

view

215 -

download

2

Transcript of Combinação de Preditores utilizando o Coeficiente de Correlação aplicado aos Problemas de...

Combinação de Preditores utilizando o Coeficiente de Correlação aplicado aos Combinação de Preditores utilizando o Coeficiente de Correlação aplicado aos Problemas de RegressãoProblemas de Regressão

Resumo

Este trabalho apresenta um algoritmo de Boosting baseado nos coeficientes de correlação entre os valores observados no conjunto de treinamento e nos valores obtidos por um algoritmo “base” de predição. A metodologia apresentada é uma modificação proposta para algoritmos de Boosting já existentes e aplicada à problemas de regressão. Para este trabalho, árvores de regressão foram utilizadas como algoritmo “base”. Os resultados obtidos foram comparados aos resultados obtidos através de Redes Neurais Artificiais, Árvores de Decisão, Bagging e os algoritmos de Boosting: AdaBoost.R e Adaboost.RT.

Autores: Luzia Vidal de Souza – UFPR

Aurora T. R. Pozo – UFPRJoel M.C. da Rosa –UFPR

IntroduçãoA técnica de Boosting é uma técnica de Aprendizado de Máquina utilizada para

melhorar a acurácia dos algoritmos de classificação. A técnica consiste em efetuar repetidas execuções de um algoritmo de

aprendizagem básico, modificando a distribuição de pesos no conjunto de treinamento e gerando uma combinação de preditores mais eficiente.

Freund e Schapire (1996) propuseram uma nova versão conhecida como Adaboost. Este algoritmo ajusta um modelo logístico aditivo cujo número de funções usadas na representação aditiva é igual ao número de iterações.

Várias outras versões desta técnica foram criadas, entre elas destacam-se os algoritmos AdaBoost.M1, AdaBoost.M2 e AdaBoost.R, este último para problemas de regressão.

Este trabalho propõe o algoritmo Boosting Improvmet Correlation (BCI) que diferencia-se dos demais ao atualizar a ponderação na combinação de preditores através de uma medida de correlação entre preditos e observados, ao invés de medidas de erro de aproximação.

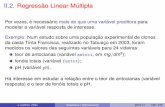

Dado T = {x1, x2, ..., xm} Inicializar o pesos na iteração 1 :P1(i) = 1/m, para todo xi Є TPara t = 1, ...,T

1.Execute um algoritmo básico de aprendizado, e determine ft, preditor para a iteração t.

2.Calcule a perda para cada exemplo:

onde y(xi) são os valores observados.

3.Calcule o coeficiente de correlação entre ft (xi) e y(xi).

4.Faça a atualização dos pesos:

Fim Para

Saída Final: obter a combinação final dos preditores, F(x):

, i = 1, ..., m-1

, i = m

Figura 1 – Algoritmo BCI

Conjuntos de Dados Observações Treinamento Teste Número de

PreditoresVariável

Resposta

CPU 209 137 72 6 Performance de CPU

Housing 506 337 169 13 Valor de Moradia

Auto-Mpg 398 262 136 7Consumo

de Combustivel

Friedman #1 1500 990 510 5 Valores Artificiais

Conclusões

Com exceção da base CPU, o algoritmo BCI alcançou melhores resultados em todas as outras bases quando comparado com Árvores de Decisão, Bagging, Redes Neurais Artificiais e os algortimos AdaBoost.R e AdaBoost.RT. Entretanto a grande diferença entre as performances deve ser analisada cuidadosamente pois não foi utilizada nenhuma forma de regularização para tornar a comparação mais honestas.

Bases BCI MT Bagging ANN AdaBoost.

RAdaBoost.

RTCPU 22,48 34,65 32,64 13,91 24,45 26,52

Housing 1,12 3,62 3,24 3,54 3,23 3,23

Auto-Mpg 0,85 3,01 2,86 3,79 2,84 2,96

Friedman #1 0,70 2,19 2,06 1,51 1,82 1,72

Materiais e Métodos

A abordagem proposta para o algoritmo da Figura 1, utiliza o coeficiente de correlação para atualização do vetor de pesos, o que influencia diretamente na minimização da função perda, pois este coeficiente fornece uma relação entre as variáveis em questão, que neste caso são valores previstos e valores observados no conjunto de treinamento. O mesmo coeficiente é também utilizado na combinação final dos preditores obtidos por um algoritmo básico.

Para a avaliação deste novo método foi realizado um experimento de validação cruzada com 4 bases de dados já testadas por várias metodologias de regressão. Foram gerados 10 conjuntos de treinamento e teste em cada uma das bases e após rodar o algoritmo, os resultados foram avaliados fora da amostra através da raiz do erro quadrático médio (RMSE).

Quadro 1 – Conjuntos de Dados

Quadro 2 – Comparação do RMSE em 10 conjuntos de teste